- 2017/10/03 掲載

Amazon Alexaとは何か? アマゾンの音声認識技術の使い方を基礎から解説する

Amazon Alexaとは何か?

しかし、現在は、「Amazon.comの音声認識プラットフォーム」といったほうが正確だろう。詳細は後述するが、「Alexa Skills Kit」というSDKや、「Alexa Voice Services(以下、AVS)」というAPI(Application Programming Interface)が公開されたことにより、サードパーティの開発者は自社のサービスにAlexaを組み込むことができるからだ。

Alexaの特徴は、ユーザーが話しかけるだけで、さまざまな情報を音声で得られることである。スポーツの試合結果や天気情報、株式・為替動向などはもちろん、「Kindle」で購入した書籍の読み上げや、「Amazon Music」からの音楽再生、さらにAmazon.comで再注文を頼むことも可能だ。

Alexa誕生の経緯

そもそも、なぜAlexaは誕生したのだろうか。Amazon.com自身が正式に表明しているわけではないが、そこには2つの理由があると考えられる。1つ目はモノを持つことができない人たちのアクセシビリティを支援するためだ。肉体的なハンディキャップがある人でも、画面やキーボードを操作することなく情報を入力/入手できる。

また、自動車の運転中や料理中など、手が塞がっている状態でも、音声だけで情報を入手したり、命令できる。「Alexa!」と呼びかけるだけで、コンピュータが起動するアドバンテージは大きい。

2つ目は、Amazon(ショッピングサイト)に対するタッチポイントの拡大だ。Alexa Skills KitやAVSを利用すれば、サードパーティは自社製品にAlexaを組み込むことができる。つまり、身近にあるデバイスから、いつでもどこでもAmazonで買い物ができるようになる。

「ECサイトにおけるアクセシビリティの確保」という観点からも、Amazon.comにとってAlexaは大きな意味を持つ。こうした理由からAmazon Alexaは生まれたと言われている。

Alexaの仕組みとは?どのように実装するのか

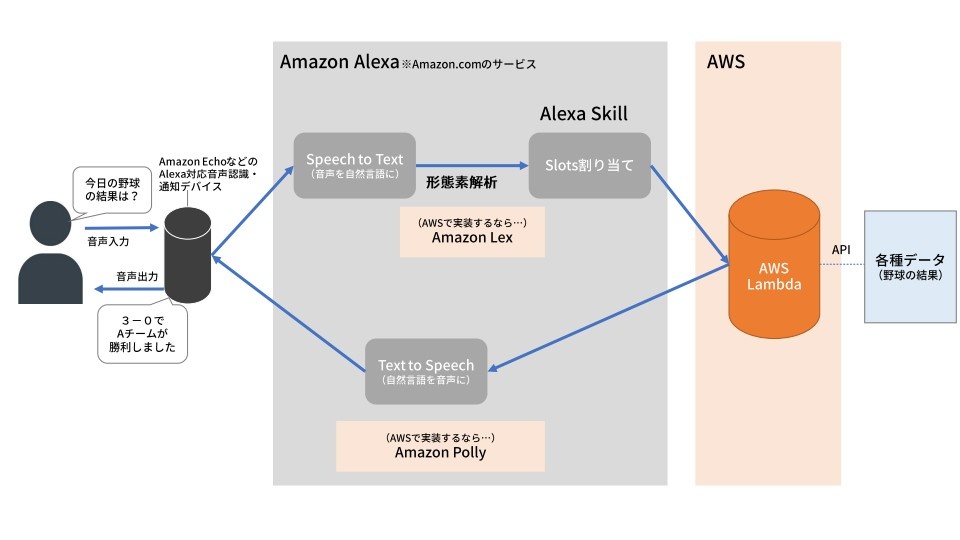

さて、Alexaの仕組みを紹介する前に、1つ明確にしておきたいことがある。それは、「AlexaはAmazon.comのサービス」であり、「Amazon Web Services(AWS)のサービスではない」ということだ。AlexaはAWSが提供する「AWS Lambda」と“連携して”動作するものの、あくまでサービス主体はAmazon.comである。したがって、Alexaそのものの具体的な内部仕様は公開されていない。しかし、実際にAWSの各サービスを利用することで、Alexaと同等のサービスを実装できるので、その仕組みを重ね合わせて見てみよう。

2.. 「Amazon Lex(以下、Lex)」を用いて「Speech to Text」機能で音声をテキストに変換し、形態素解析する(正確にはAmazon LexがAlexa同等の機能を備えている)。なお、Lexは音声やテキストを使用した会話型インタフェースを構築するためのサービスであり、音声認識や曖昧なキーワード(いわゆる自然言語)に対応している。

3.テキスト変換されたデータを基に、ユーザーの「Intent(インテント)」を判断し、開発者の設定に応じて「Slots(スロット)」に割り当てる。

インテントとは「意思/意図」という意味だが、この場合はユーザーが知りたい内容(情報)を指す。スロットは、インテントを得るために必要な入力データ(パラメータ)のことだ。たとえば、「今日のAチームの野球の試合結果を教えて」と音声入力したとしよう。この場合、インテントは「Aチームと対戦チームのスコア」であり、スロットは「今日」「Aチーム」「試合結果」となる。

4.スロットに当てはめられたデータを「AWS Lambda」に引き渡す。AWS Lambdaはクラウド上でアプリケーションを実行するイベント駆動型のプログラム実行環境(プラットフォーム)だ。ストレージ、データベース、ログといったAWSのサービス群が包含されている。

5.AWS Lambdaでスポーツ結果を集計しているデータベースにAPIを介してアクセスし、スロットの割り当てに応じてデータを取得する。

取得したデータはAWS Lambda上で文章に変換し、Alexaに返す。この時点ですでに文章になっているのがポイントだ。

6.返された文章は「Text to Speech」機能で音声化し、Amazon Echoに渡す。音声化の技術はAWSでは「Amazon Polly」がある。ちなみに、天気や時間、アラーム機能などの簡単なインテントは、Alexaに標準でライブラリが格納されている。

以上がAlexaの一連の動作の流れである。

Alexaの“すごみ”は、この仕組みを支える技術を「プラットフォーム」としてAWSが提供していることだ。“入り口”となるSpeech to Text から“裏側”となるAWS LambdaのAPI処理までが、シンプルで使いやすいサービスとして個々に利用が可能になっている。そのためEchoなどの公式デバイスを使わずに、同等の仕組みを開発することも難しくない。

開発者は実行環境(プラットフォーム)の構築など、余計な作業をすることなく、自社独自のサービス開発にフォーカスできるのだ。

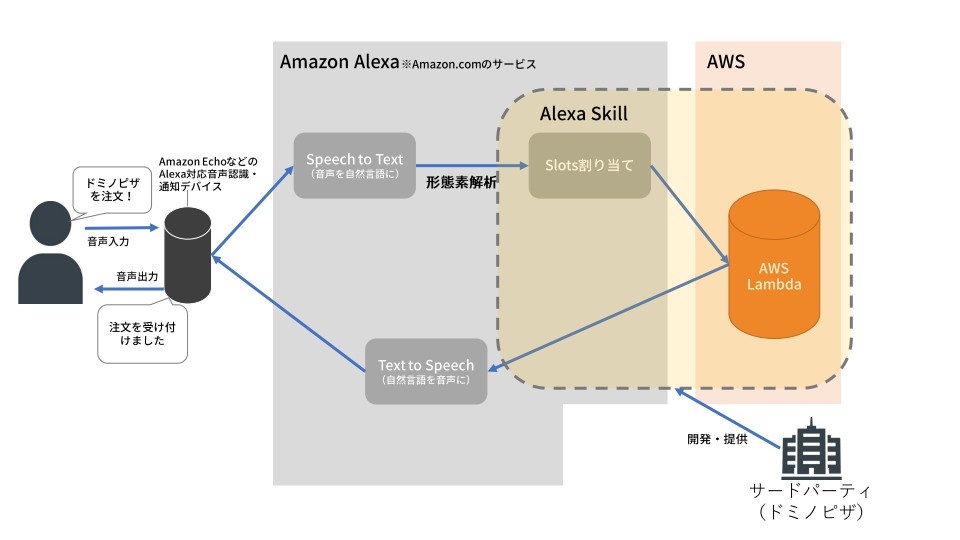

サードパーティが開発するAlexa Skillとはいったい何か?

次に、サードパーティがAlexaを利用してどのようなサービスを提供できるのか見てみよう。前述したとおり、Amazon.comは「Alexa Skills Kit」というSDKや、AVSというAPIを無償で公開している。Alexa Skill(以下、Skill)はAlexaの機能を実行できるライブラリのようなものだと考えればわかりやすい。

サードパーティの開発者はAlexa Skills Kitを使ってSkillを開発し、「Alexa Skills Marketplace」に自作のSkillを公開する。2016年の1月には130だったSkillだが、2017年2月には1万超のSkillが公開されている。なお、各種Skillは、コンパニオンアプリを通して無料でダウンロードすることが可能だ。

Skillの開発は、Uberやドミノピザ、LG、Samsung電子といったグローバル企業だけでなく、ベンチャー系企業も積極的に行っている。

たとえば、ドミノピザは、Amazon Echoに向かって「Alexa、『ドミノデラックス』のLサイズ2枚」と音声入力すれば注文が確定し、最寄りのドミノピザから商品が届くSkillを開発した。

もちろん、ユーザーはドミノピザのホームページやアプリ上で、名前、住所、支払い情報といった「ピザプロフィール」を事前に設定し、Alexaアプリで自身のアカウントとピザプロフィールを連携させる必要がある。

しかし、一度設定をしてしまえば、あとは簡単だ。将来的にはドミノピザSkillと会話しながら、商品を選択するといったことも可能になる。

一方、スタートアップが提供するSkillは玉石混交だが、ユーザーターゲットを絞ったものや、“あったらあったで便利”なSkillが多い。「The Bartender」というSkillは、カクテルのレシピや作り方を音声でナビゲートするものだ。

また、エクササイズ・アプリの開発を手がけるPargeeは、「7-Minute Workout」というSkillを公開。7分間のトータルエクササイズを音声で指示してくれるという。

年内に発表される日本版では、NTTドコモ、クックパッド、KDDI、積水ハウス、ソフトバンク、日本放送協会(NHK)、JR東日本、三菱UFJフィナンシャル・グループ、ヤフー、リクルートホールディングスがすでにSkillの提供を表明しており、今後、続々と対応機能が明らかになってくるはずだ。

Alexa対応デバイスの現状、搭載事例

Amazon.comが提供するAlexa対応の純正デバイスは、Amazon Echoのほか、「Amazon Tap」「Echo Dot」「Amazon Fire TV」がある。一方、サードパーティがAlexaを自社開発のデバイスに組み込むには、無償提供されているAPIのAVSを利用すればよい。

Alexaの実装デバイスでインパクトを与えたのは、韓国LGとサムスン電子の「スマート冷蔵庫」だろう。2017年1月開催の「Consumer Electronics Show(CES)」で披露した。両社製品とも前面ドアに大きなタッチパネル、マイクとスピーカーを備える。

面白いのは生鮮食品配送サービスの「Amazon Fresh」と連携し、冷蔵庫に直接話しかけるだけで食材が届くことだ。つまり、事前にAmazonアカウントを登録しておけば、冷蔵庫の前で在庫を確認しながら足りない食材名を言うだけで、それがAmazonでのショッピングになっているというわけだ。

こうしたサービスは、日本の都市部ではまだ必要性が感じられないかもしれない。では、業務用冷蔵庫にAlexaが搭載されていたらどうだろう。

仕入れの発注や伝票管理といった事務処理は、時間も手間もかかる。それが「冷蔵庫の前で話す」だけで、発注と支払伝票作成、そして支払いが完了するのだ(Amazonで購入すれば、納品書と領収書が自動で発行される)。

つまり、冷蔵庫が「日々の煩わしい作業を解決するデバイス」になる。こうしたアイデアは無限大だろう。今後は業種/業界を問わず、さまざまなデバイスが続々と登場するはずだ。

なお、日本市場向けにAVSを使用したAlexa対応製品については、アンカー・ジャパン、HTC Corporation、オンキヨー、ハーマンインターナショナルなどの企業が発売を計画しているという。

なぜAlexaが注目を集めるのか? SiriやCortanaとの違い

最後に、なぜAlexaが注目されているのか考えてみたい。音声認識サービスには、マイクロソフトの「Cortana」や、アップルの「Siri」、そしてグーグルの「Google Assistant」がある。どれも音声を認識して内容を理解し、音声で返答するという機能に変わりはない。

Alexaがほかの音声認識サービスと大きく異なるのは、そのプラットフォームが開放されているという点だ。アップルもグーグルも自社の音声認識技術を積極的に開放してこなかった中で、サードパーティが新たなアプリ(Skill)をどんどん構築すれば、Alexaの魅力はますます増していく。

マルチクラウドという言葉が出てきてしばらくたったが、音声認識サービスではやはり各ベンダーの展開するパブリッククラウドとの連携が強い。AmazonはAWSとしてクラウド事業を展開するときも他社より早く動いた実績がある。AWSを扱うベンダーが多いため、間口が広いことはもちろん、AWSで得た成功体験を活用し音声AIアシスタントの業界でも突出していくとみられる。

それに加えて、バックグラウンドにはAmazon.comの巨大なECサービスが控える。FBA(フルフィルメント by Amazon)、Amazonログイン&ペイメントなど、細かく切り出してきた同社のEC関連機能とそのまま連携できる強みは他社にはない魅力と言えるだろう。

今や音声認識デバイスは「スマートホーム」の本命とされる。音声認識で一歩先を行くAlexaの今後の動向には大いに注目すべきだろう。

関連コンテンツ

関連コンテンツ

PR

PR

PR