- 会員限定

- 2019/04/05 掲載

人工知能×VR/ARはなぜスゴいか、「味覚の操作」が可能になった背景

連載:中西 崇文のAI未来論

AIとARの組み合わせによって味覚を錯覚させる

これまで、人間がコンピューターを利用する際のインターフェースは、視覚や聴覚を頼るものが多かった。PCの場合は画面やスピーカーのことだ。誰もが持つようになったスマートフォンは、バイブレーション機能がある。最近は触覚を使うコンピューターが普及したと言えるだろう。感覚のチャネルが加わるほど、より現実に近いUXを提供できる。人間の五感に訴えられる情報が増えるからである。

最近の研究で、AIとARを組み合わせると、「味覚を錯覚させる」ことができるかもしれないという結果が出た。

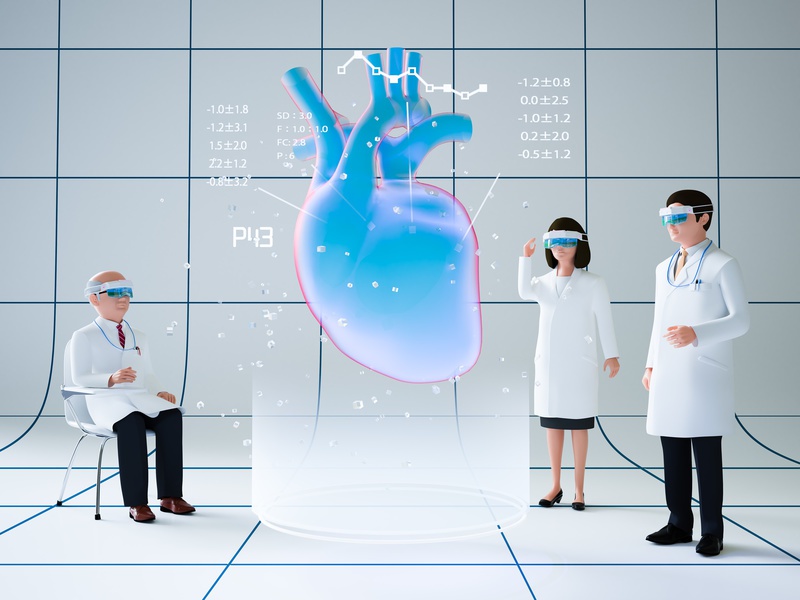

奈良先端科学技術大学院大学、電気通信大学などによる研究チームは、AIとARを使うことによりリアルタイムの味覚操作システムを実現している。

実際の食品が画像を、リアルタイムに別の食品の外観(色やテクスチャ)に変換することにより食感を錯覚させるというものである。実際はそうめんを食べているのに、ラーメンや焼きそば、カレーうどんなど、別の食べ物を食べているように思わせるといったことだ。

処理サーバでは、AI技術により、その実際の食品の画像から別の食品画像に変換し、ARゴーグルに返すことにより、現在の画像に変換処理した画像を重畳させる。

食品から別の食品への変換には、2つの対立するネットワークをトレーニングすることにより新たな情報を生成することが可能な「敵対的生成ネットワーク(GAN)」を用いている。

実際の食品の状態に合わせてリアルタイムかつインタラクティブに変換される。元の食品の状態を維持しながら変換されるため、変換後に錯覚が起きやすくなっているのだ。

訓練データとして、ラーメン、焼きそば、白ご飯、カレーライス、チャーハンの5種類の画像を合わせて、14万9370のデータセットを用意して学習を行っている。

AIとVR/ARの融合が新たな体験を生む

AIとVR/ARはそれぞれが注目されたキーワードではあるものの、それぞれ独立に語られることが多い。これらを組み合わせることにより、人間に新たな感覚を創ることが可能となり、それが新たなUXを形成する。VR/ARは、コンテンツをどのように作り込むかが重要であり大変な問題である。特に動的でインタラクティブなコンテンツを作成することになれば、非常に多くのコストがかかる。そこにAIを導入することは製作現場の視点でも非常に魅力的である。

AIを使うと、訓練データを集めて学習し、パラメーターを設定して、構成するための労力は発生するだろう。だが、一度学習が完了すれば、入力に応じて非常に素早く出力を構成することができる。

先に説明した味覚操作システムの場合、実際の食品の画像を入力し、変換後の食品画像へ出力するという構成にははあまり時間がかからない。さらに、入力画像の状態に応じて、その状態を反映した形で変換後の出力画像を構成する。

つまり、いったんAIの構成や学習が完了すれば、コンテンツを作り込む必要がなくなる。入力画像に対して、リアルタイムかつ動的に、インタラクティブな「変換後の画像」を構成できるのだ。

このように視覚を変換しながら、その他の感覚を刺激すれば、刺激により感覚を錯覚させることができる。感覚を錯覚させ、変換させると、通常存在し得ない事象をリアルに体験できる。

体験は我々の感性を刺激する。これまでのインターフェースは情報を情報として受け取るものであったが、AIとVR/ARの融合により、情報を実体験として受け取ることになるということだ。その実体験が我々の創造力をより増大させてくれる。

【次ページ】デジタルツインが一般的になる世界

関連コンテンツ

関連コンテンツ

PR

PR

PR