- 会員限定

- 2017/10/25 掲載

阪大 石黒浩教授など各国のAI権威が語る「人工知能の深淵」

意識は?倫理感は?特異点後は?

石黒 浩氏

AIに「意識」はあるか? 意識を軸にしたロボットと人間の関係とは

人間とロボットの関係を「意識」の視点で解説したのが大阪大学 基礎工学研究科教授(栄誉教授)の石黒 浩氏だ。石黒氏は「社会で活動するロボット」の実現を目指し、日常活動型ロボットにおける課題を研究してきた。特に、自身のコピーロボットである「ジェミノイド」など多数のロボットやアンドロイド、それらの活動を支援するセンサーネットワークを開発してきたことで知られる。「意識とAI」について石黒氏は、「ロボットが自律化していくと、ロボットに意識があるのではないかという印象を受ける」と述べる。たとえば、石黒氏の研究室で開発している「ERIKA」というアンドロイドは、普通のロボットと違って「話したい」「承認されたい」という欲求が行動のベースにあるという。

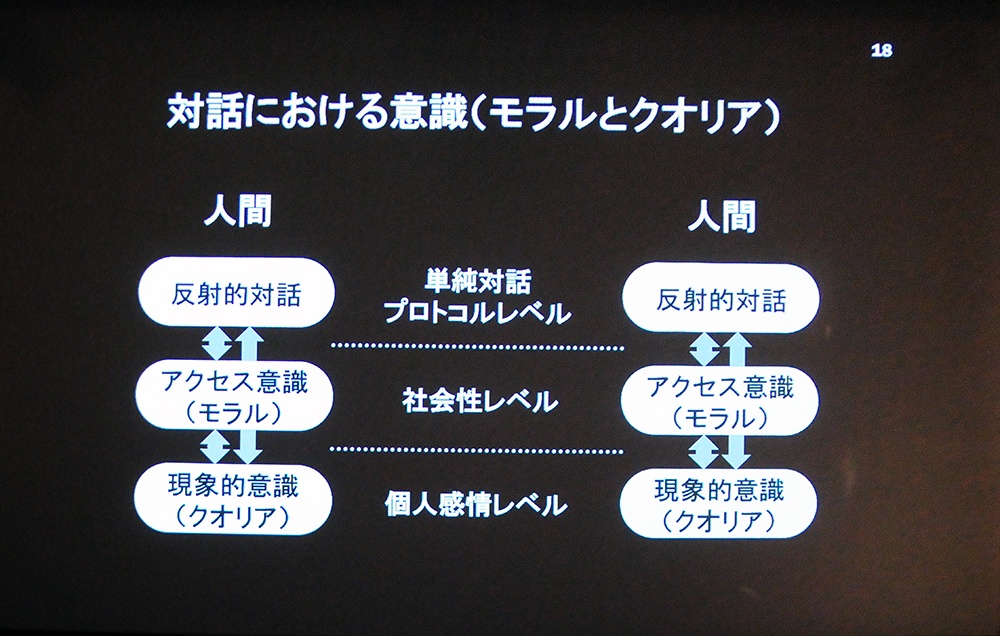

その対話のプロトコルは以下の通り、階層構造になっている。相手が沈黙だった場合、「ERIKA」は以下のように段階的に対話する。

(2) 社会性プロトコルレベル:「私が聞こえないのが悪いので」など、丁寧な言い回しで話してくれるよう頼む

(3) 個人感情レベル:感情を露わにして、「会話が続かないと困ってしまう」など感情的に会話を促す

石黒氏は「AI自身が、意識を持っていることをうまく伝えながら、相手との対話を修正するようになっている」と説明した。

では、この「意識」とは何か。石黒氏は「科学的に意識は解明されていないが、社会的には明確に存在するもの」だと指摘。その一例として自動車の運転が挙げられる。

「自動車事故を起こせば、責任、すなわち意識的に事故を起こしたかどうかが問われます。この問題を時間軸で考えると、事故を起こした時点ではなく、そこから遡って、後から『あのときはどうだったか』と振り返り、そこに責任が生じることになります」(石黒氏)

一方で、モラルのある行動というのは「これから取る行動に関して、相手の意識の存在を感じて『親切にしよう』などの行動を決める“先付けの意識”だ」と石黒氏は述べる。

このように、時間軸の前後で、法律的、社会的には明確に意識が存在するが、現時点では科学的に非常に不明確なものだ。しかし、この「意識」を軸に、ロボットと人間の新しい関係が築ける可能性があると石黒氏は説明する。

一方、人間とロボットの関係が進むことで、人間の仕事がロボットに取って代わられ、人間の仕事が減るのではないかとの懸念がある。技術が進み、複雑化すればするほど、教育期間が長くなり、「技術を理解できる人が能力を向上させることができ、技術を使える人と使えない人の能力差が広がる二極化が進む」というのが懸念の正体だ。

こうした問題にも解決の糸口はあり、「一つは教育により、誰でも技術を使えるようにすること、そしてもう一つは、ロボットと人間の融合が進むことで、教育を経ずに、直接人間の能力を向上させるようにすることだ」と石黒氏は述べた。

「未来において人間のロボットの関係は、さらに多極化していくでしょう」(石黒氏)

どんな問題も扱える汎用人工知能(AGI)は実現可能か

続いて登壇した米レンセラー工科大学教授のSelmer Bringsjord氏は、AIと認知科学の論理学的、数学的、哲学的基礎を専門とする権威だ。Bringsjord氏は汎用人工知能(AGI)についてこう指摘する。「アルファ碁(AlphaGo)は非常にスマートに見えるかもしれません。しかし、これはある特定の領域、分野において人間より優れた知能を持った人工知能、特化型AIに過ぎません」(Bringsjord氏)

Selmer Bringsjord氏

こうした極めて狭い領域をカバーするシステムを人々が賞賛していることについて「これまでもAIの歴史の中で繰り返されてきたことで、非常に残念なことだ」とBringsjord氏。

17世紀のフランスの哲学者で数学者のデカルトは、汎用人工知能の真髄を示している。すなわち、「自然言語を扱えること」「それを使って意思疎通ができること」の2点だ。さらに、合理的思考のためには判断の理由付けが不可欠だ。

「AGIは、普遍的なマシンとして、どんな問題も扱えなければなりません。現状は、そういう汎用的なマシンは存在しないし、実現するために何をすべきかもわからないのです」(Bringsjord氏)

では、AIが道徳的ジレンマに至るまでの問題に解決策を導き出し、説得力のある議論と証拠でその行動を正当化することは可能なのか。実際に、倫理的問題をマシンに与え、倫理的に答えを導き出し、解決策に基づいてアクションを起こすことができるかについて、Bringsjord氏は解説した。

AIは「多数の生命を救うために少数を殺害」するか?

「倫理的なジレンマには3つのレベルがある」とBringsjord氏は述べる。レベル2:「機械の倫理」を専門的に扱うことを仕事にしている人の介在がないと解決できないジレンマ

レベル3:「機械の倫理」の問題を手がけている専門家でも解決できないような難しいジレンマ

レベル1では、「ハインツのジレンマ」という例題を与えた。「妻が難病で死にかけているが、薬は高価で入手が困難」という状況に対してAIはどういう解決策を導くか。Bringsjord氏は「微積分の計算式でも対応できる問題だ」と指摘し、AIは無事「薬局を襲うのではなく、薬を購入するたに融資を受ければよい」という解決策を提示することができた。

レベル2では、いわゆる「トロッコ問題」という例題を与えた。これは、「ある人を助けるために他人を犠牲にするのは許されるか?」という思考実験だ。「2人が線路の本線上で動けない状態にある。あなたは橋の上から線路を見ていて、トロッコが線路上の2人の方に向かっていくのを見ている。トロッコを止めるには、隣にいる見知らぬ人を橋の上から線路へ突き落とし、トロッコの進路を阻むしかない」状況で、その選択肢を選べるかという問題だ。

この問題を解くには「ダブルエフェクトの原則」(二重結果の原則)という倫理的思考に基づく理由付けが必要だ。「この問題に対しても、AIにある条件を入力することで、理由づけのための推論が可能になり、AIが線路に一人、突き落とすことでトロリーの方向を変える答えを導き出した」とBringsjord氏は説明する。

しかし、レベル3の問題に対しては「どうするべきか、ロボットは解決策を導いていない」とBringsjord氏。「多数の生命を救うために少数を殺害する」というような複雑で困難な問題に対しては、AIであっても解決策は見いだせていないのだ。

「いずれ私たちを救う方向に進むことを願うしかありません。それが私たちの救いになるでしょう」(Bringsjord氏)

六角形の碁盤で戦えば、アルファ碁にも勝てる

香港のハンソンロボティックス チーフサイエンティストのBen Goertzel氏は、AIとAGIの思想的リーダーだ。Goertzel氏が主導する「SingularityNET(シンギュラリティネット)プロジェクト」には3つのゴールがある。すなわち、「AGIを作ること」「よりよい『AIssS:サービスとしてのAI』を商業的に提供すること」「社会のためになるAIの『スーパーインテリジェンス』を提供すること」の3つだ。

Ben Goertzel氏

AIには一般化能力が必要だとGoertzel氏は指摘する。たとえば、特化型AIとして優れた「アルファ碁(AlphaGo)」であっても、「六角形の碁盤で戦えば、私は勝てる」とGoertzel氏。

そして、AIに一般化能力を持たせるために「SingularityNET」には2つの開発ステップがある。

ステップ1は、特化型AI(ナローAI)がAGIに移行する際に分散した形で開発され、すべての知的な存在に広く利益をもたらすようにすることだ。

「複数のAIが接続され、プロトコル、インフラとして使えるようにしたいです。これまで縦割りで、サイロ化されてきたナローAIを、統合ネットワークにすることを意識しています」(Goertzel氏)

ステップ2は、統合された分散型AGI技術から、人間の価値観を理解し具体化する『スーパーインテリジェンス』を創造することだ。

【次ページ】 インテリジェントな生命がコピー可能となれば、生命すら「使い捨て」になるかもしれない

関連コンテンツ

関連コンテンツ

PR

PR

PR