- 会員限定

- 2023/01/18 掲載

責任あるAI(レスポンシブルAI)とは?「AI倫理」「説明可能なAI」とは何が違うか

責任あるAIとは

AIは潜在的にいくつかのリスクを抱えています。たとえば、AIが人種差別や性別差別につながる判断を下してしまうこともあれば、誤って個人情報を流出させてしまうこともあるでしょう。しかし、AIの判断や行動の責任をAI自身に求めることはできません。そこでAI開発に携わる企業には、開発したAIの公平性や安全性を担保していく責任があるのです。責任あるAIとは、AIが抱える公平性や安全性などに関わる問題を解消すべく、AIを開発する企業やそれを利用する関係者が責任を持って取り組む際の指針のことを指します。

なお、この責任あるAIという言葉は、比較的広い意味で使われています。たとえば、アクセンチュアの定義によると、「顧客や社会に対してAIの公平性・透明性を担保する方法論」とされています。そのほか、開発するAI自体のことを指して「信用/信頼できるAI」という意味合いで使うこともあります。

この「方法論としての責任あるAI」の考え方には、「信用/信頼できるAI」も含まれているため、本記事では方法論として責任あるAIというキーワードを扱いつつ、そこに含まれる「信用/信頼できるAI」についても解説していきます。

責任あるAI、注目されはじめた背景

責任あるAIという概念は、社会的な課題を解決するために生まれた経緯があるため、まずは注目されるようになった背景から説明します。責任あるAIの考え方の出発点になるのが、私たちがAIを利用する上で、法的・倫理的な観点から「AI自身に責任をとらせることができない」という問題です。

AIが人間に被害を与えてもAIは賠償金を払うこともできませんし、刑罰を与えても、謝罪をさせても、そこに大きな意味はありません。そのため、AIによって自律的に行われる「行為」に対して責任をとるのは基本的にはAIに関わる人間になります。多くの場合、AIの使用者か製造者が責任を負うことになるでしょう。

しかし、使用しているAIについて詳しい情報が使用者に明かされていなければ使用者が責任を負うことは難しく、明かされていたとしても使用者が情報を理解できるとは限りません。また、製造者側も問題の原因が正しく把握できるようになっていなければ、本当に製造側に責任があるのか把握できないため、安易に責任を認めることも難しいでしょう。

また、AIの問題は使用者と製造者の間に留まらず、AIに関わるあらゆる人間にさまざまな影響を与えます。その影響が大きすぎれば、使用者や製造者が責任をとれる範囲を超えてしまうこともあるでしょう。つまり、AIを扱う際に生じる「責任」の問題は、利用する関係者間の問題でなく、社会全体の問題なのです。こうした社会の要請に対して、AIを研究・開発・使用する上で「誰にどんな責任があるのか」を明確にすることが「責任あるAI」の重要な目的の1つとなります。

責任あるAI、類似キーワードとの違い(図解)

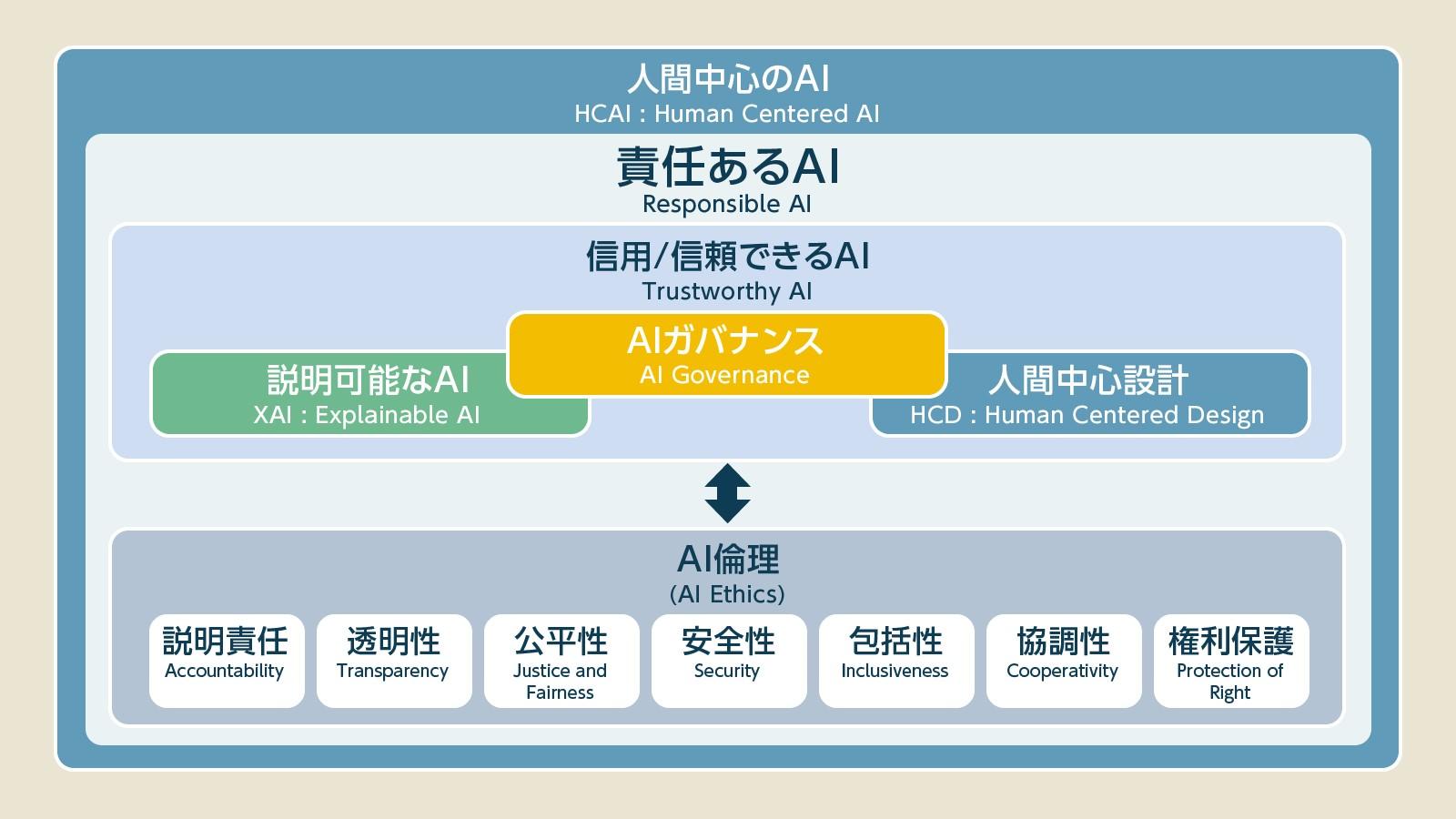

AIに関わる責任の所在を明確にするための方法論(責任あるAI)を実行するためには、「AI倫理」や「説明可能なAI」「人間中心設計」「AIガバナンス」といったものが必要になります。それぞれの関係を整理したのが、下記の図です。この図に沿って、それぞれの関係を説明すると、AIが守るべき原則を「AI倫理」によって規定し、その原則を守るために必要な技術として「説明可能なAI」が存在し、安全なAI運用を行うために人間とのインタラクションが考慮された「人間中心設計」というアプローチがあり、それらを実践するための環境を整えるのが「AIガバナンス」という位置付けになります。

このイメージ図にならい、適切なガバナンスによって運用されるAIは、「信用/信頼できるAI」と言えるでしょう。さらに、この責任あるAIの方法論の中で目指すAIの在り方こそが、AIは人間を中心にして運用がなされるべきという「人間中心のAI」という考え方なのです。

このほかにも細かな要素はありますが、まずはこの図で紹介した「AI倫理」「説明可能なAI」「人間中心設計」「AIガバナンス」について解説していきます。

超重要関連キーワード:AI倫理

AI倫理とは、顧客や社会の利益を守るために、AIとAIを運用する組織や人間が守るべく作られた規範です。責任あるAIを実践するためには、まずは企業・社員・AIが守るべきルールを定める必要があるということです。AI倫理はその基盤となる部分であり、最初に取りかかるべき課題です。倫理・原則は、拘束力のある法律ではないため、AIに関連する団体や企業がそれぞれの考えで倫理的な指針を定めており、内容が微妙に異なります。しかし、大まかな方向性は同じです。以下に、日本の人工知能学会、グーグル、マイクロソフトが掲げている倫理指針を比較してみましょう。

■人工知能学会『人工知能学会倫理指針(2017/02)』

(1) 人類への貢献 (2) 法規制の遵守 (3) プライバシーの尊重 (4) 公正性 (5) 安全性 (6) 誠実な振る舞い (7) 社会に対する責任 (8) 社会との対話と自己研鑽 (9) 人工知能への倫理遵守の要請

■Google『GoogleにおけるAIの応用目的』

(1) 社会に利益をもたらすこと。 (2) 不公平なバイアスを産まず、強化しないこと。 (3) 安全性を高めるための開発とテストを行うこと。 (4) 説明責任を果たすこと。 (5) プライバシー保護の原則を徹底すること。 (6) 高い科学水準を維持すること。 (7) この原則に従って技術を提供すること。

■Microsoft『Microsoftの責任あるAIの基本原則』それぞれ似ている部分もあれば、異なる部分もあることが見てとれます。また、異なる表現を使っていても詳しい説明を見てみると、内容的には同じことを言っている場合もあります。

(1) 公平性 (2) 信頼性と安全性 (3) プライバシーとセキュリティ (4) 包括性 (5) 透明性 (6) アカウンタビリティ

こうした倫理的な原則に関する議論はIEEE(米国電気電子学会)の「倫理的設計(EAD_v2)」で詳細に行われたほか、OECDでも「AI利用の原則」としてまとめられています。また、欧州委員会では「信用できるAIのための倫理的指針」や、それに基づく「倫理的アセスメント」などが出されています。

AI倫理に関する指針には非常に多くの論点があり、それを整理する組織や団体によって内容が微妙に異なりますが共通点も多いです。共通点を大雑把にまとめると下記のようになります。

■説明責任こうした論点はあくまで倫理原則の一例に過ぎませんが、基本的に「人間と社会に対して十分に配慮し、AIに関する説明責任を果たす」という点に重きが置かれています。

AIがもたらす結果とその過程に関して、企業はユーザーにきちんと説明しなければならない(例:不具合に関する公式な説明。データ利用に関するポリシーの公開…など)。

■透明性

AIの入出力のプロセスやデータの利用方法について、企業・ユーザーが理解・把握できる構成になっていなければならない(例:AIのブラックボックス化の回避。ソースコードのオープン化…など)。

■公平性

AIはすべての人々・社会に対して公平でなければならない(例:人種・性別に対する差別的な出力を行わない。社会に存在する差別を反映しない…など)。

■安全性

AIは高い信頼性と安全性をもって人々に提供されなければならない(例:徹底した検証の実施。一定水準以上の精度…など)。

■包括性

AIはマイノリティを含めたすべての社会に対して利益をもたらす存在でなければならない(例:社会貢献。利益の共有。すべての人々に配慮された設計…など)。

■協調性

AIは社会の中で人間と協調して実装されなければならない(例:人間を支援するAI。人間に監視されるAI。人間に危害を加えないAI…など)。

■権利保護

AIは人間のプライバシーを含め、各種権利の保護に努めなければならない(例:プライバシーに配慮したデータ設計。既存の職種に配慮した実装…など)。

このようなAI倫理を遵守するための方法として「説明可能なAI」「人間中心設計」などがあり、さらに責任あるAIが目指すべき社会の在り方を考えたものが「人間中心のAI」です。責任あるAIに関わる重要な技術・概念なので、しっかり抑えておきましょう。

【次ページ】超重要関連キーワードをまとめて解説、「説明可能なAI」「人間中心のAI」「AIガバナンス」とは?

関連コンテンツ

PR

PR

PR