- 会員限定

- 2024/10/31 掲載

Phi-3.5とは何かを解説、マイクロソフトの「GPT-4o miniとほぼ互角」AIの真価

マイクロソフトのオープンソースモデル「Phi-3.5」とは

生成AI分野では、かつてGPT-4などのクローズドソースモデルとオープンソースモデルに大きなパフォーマンスの差があった。しかし最近では、メタのLlama3.1などに見られるように、オープンソースモデルの追い上げが顕著となっており、その差はほとんどなくなりつつある。そうした中で、Llamaに並ぶ代表的なオープンソースモデルとして認識されており、その開発動向には多くの注目が集まっているのがマイクロソフトの「Phi」シリーズだ。

Phiシリーズは現在、最新版である「Phi-3.5」ファミリーがリリースされている。

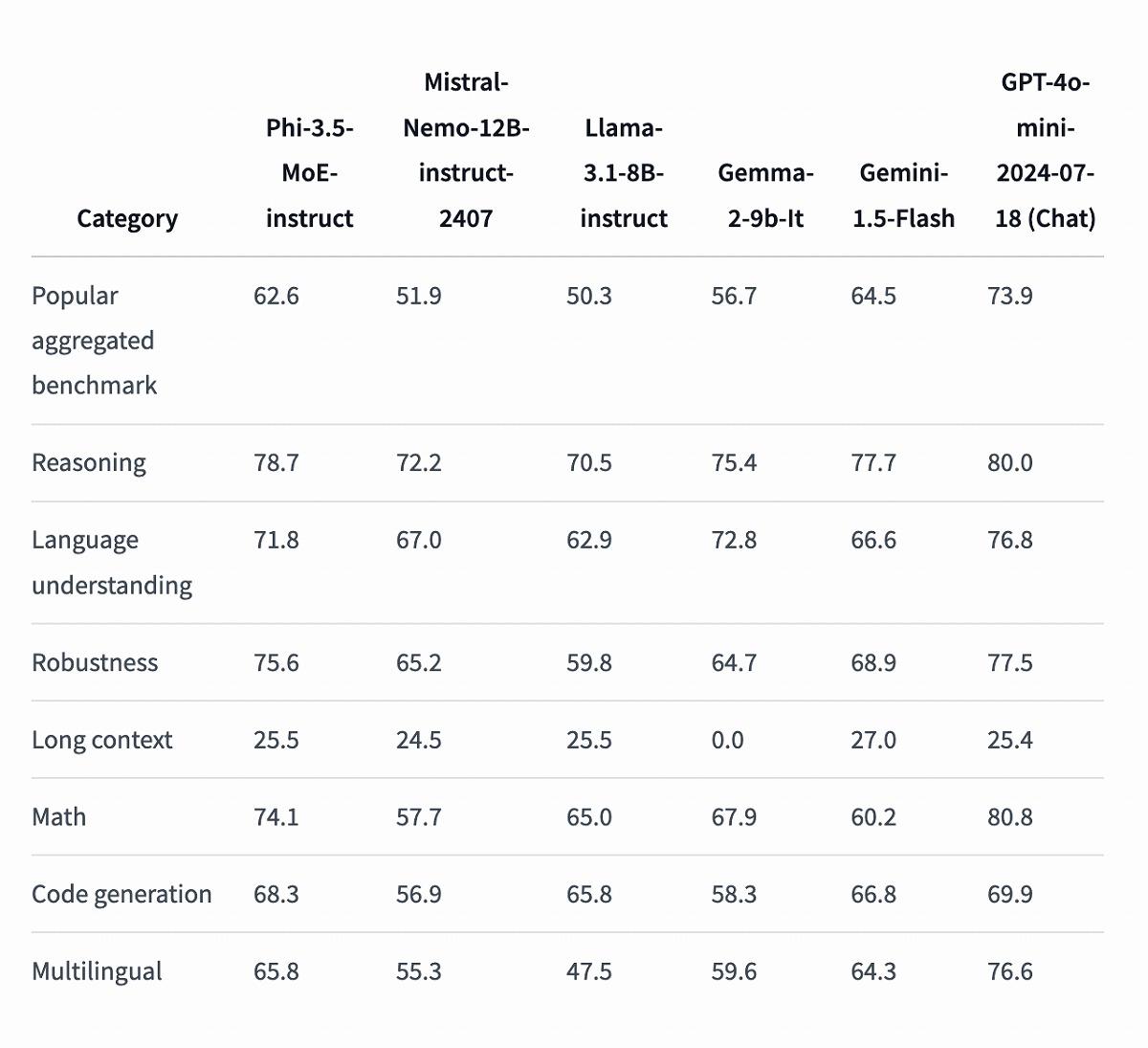

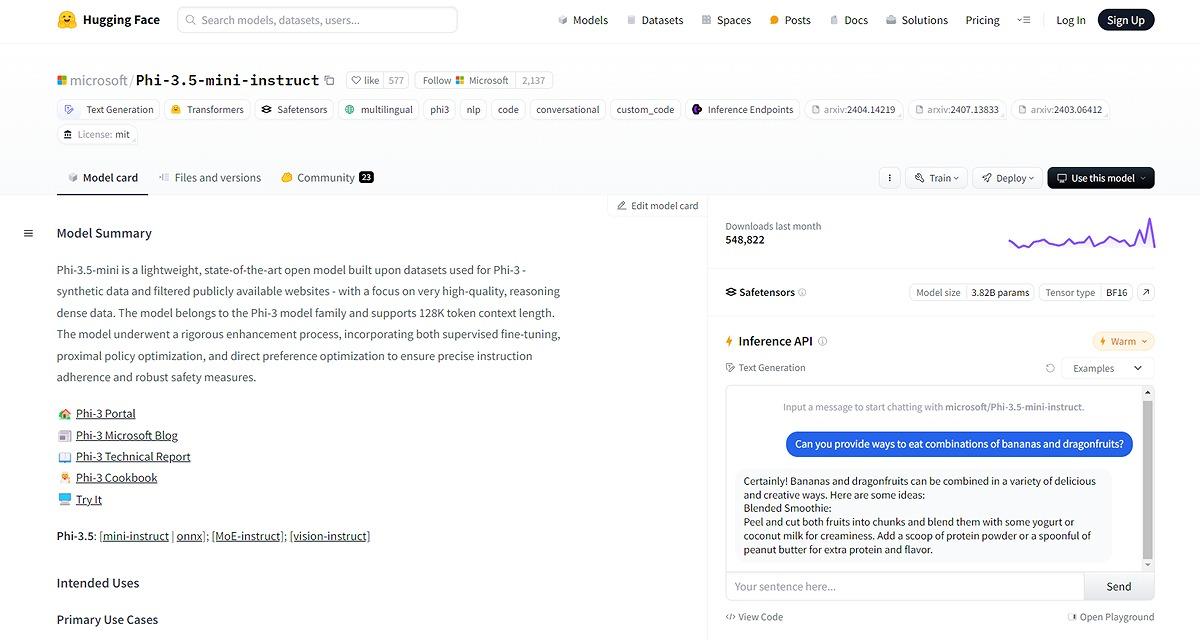

「Phi-3.5」ファミリーは3つのモデルで構成される。38億2000万パラメータの「Phi-3.5-mini-instruct」、419億パラメータの「Phi-3.5-MoE-instruct」、そして41億5000万パラメータの「Phi-3.5-vision-instruct」だ。これらのモデルはHugging Faceで公開されており、ダウンロードして利用することができる。また、Ollamaでも利用可能だ。3モデルともMITライセンスでの提供となっており、開発者は自由にモデルを利用し、自社サービスに組み込むことができる。

3モデルで特に注目の「Phi-3.5-MoE-instruct」

そんな「Phi-3.5」ファミリーの中でも特に注目されるのがPhi-3.5-MoE-instructモデルだ。このモデルは、419億のパラメータを持つとされるが、Mixture of Experts(MoE)アーキテクチャを採用しているため、実際に動作するのは66億パラメータのみという。MoEは、複数の「専門家」モデルを組み合わせ、タスクに応じて最適なモデルを選択する仕組み。コンピューターリソースを節約しつつ、高パフォーマンスを実現するアーキテクチャとして、いくつかのモデルで採用されている。

トレーニングデータに関して、Phi-3.5-MoE-instructは4兆9000億トークン(そのうち10%が多言語)を用いて学習された。特筆すべきは、データの質が大きく改善された点だ。厳選された公開文書、高品質な教育データ、コード、合成データ、そして人間の選好を反映した高品質なチャット形式の教師付きデータが使用されたという。

マイクロソフトはモデルの推論能力を向上させる上で、データの質が重要と考えており、Phi-3.5の開発においても、データセットのフィルタリングに力を入れたとされる。 【次ページ】GPT-4o miniと「ほぼ互角」の実力とは

関連コンテンツ

関連コンテンツ

PR

PR

PR