- 会員限定

- 2024/10/04 掲載

グーグル「Gemma」は何がすごい?試してわかる小型言語モデルで「GPT-3.5超え」の実力

小型モデルの飛躍的な進化、最近の動向

大規模言語モデル(LLM)の進化は、パラメータ数の増大とともに進んできた。たとえば、OpenAIのGPT-3は1750億パラメータを持ち、その後継モデルGPT-4に至っては、パラメータ数が1兆を超えると推定されている。こうした巨大モデルの運用には、膨大な計算リソースが必要となり、そのコストは天文学的な数字に上る。しかし、最近の技術革新により、パラメータ数が数億から100億以下の小型言語モデルが目覚ましい進化を遂げている。これらのモデルは、低コストかつローカル環境でも運用可能でありながら、高いクオリティを実現している。

マイクロソフトが2024年4月に発表した「Phi-3」は、その代表例だ。

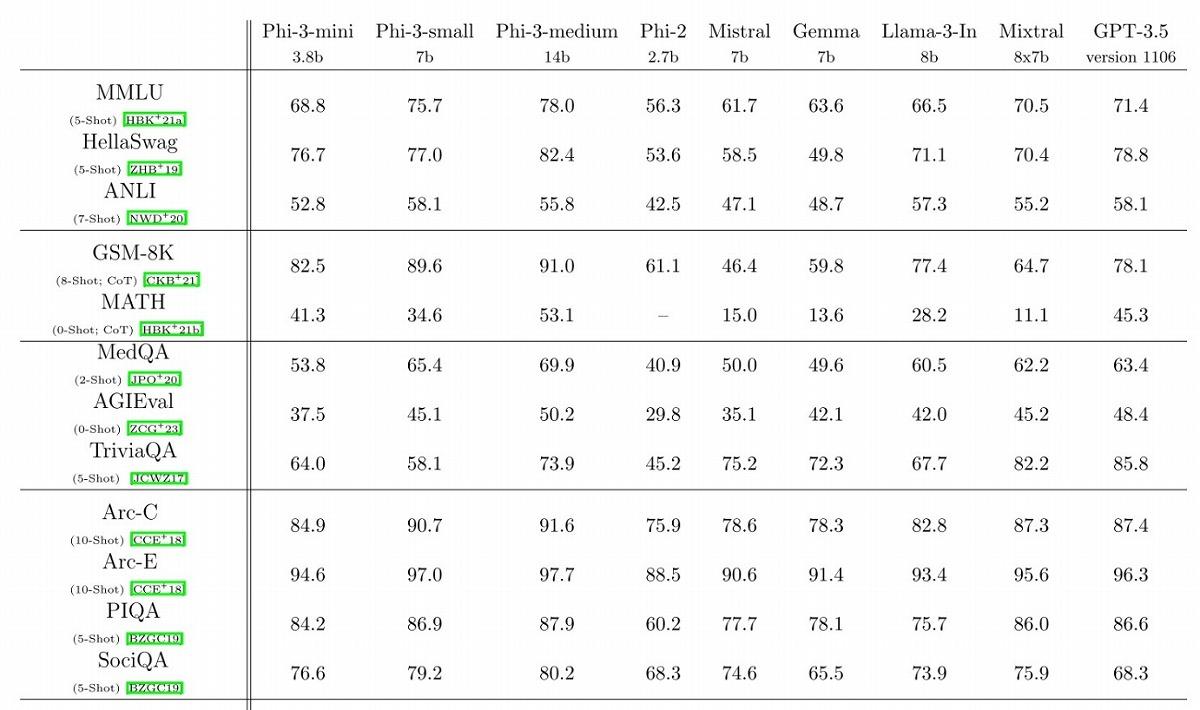

Phi-3の最小モデル「Phi-3-mini」は、わずか38億パラメータでありながら、法学、数学、哲学、薬学などの幅広い分野の知識を問うベンチマークテスト「MMLU」で68.8%を獲得。OpenAIのGPT-3.5(71.3%)に迫る数字を記録した。さらに、算数問題の解決能力を測るGSM-8Kでは82.5%を達成し、GPT-3.5の78.1%を上回った。

メタも小型モデルの開発に注力している。同社が2024年6月末に発表した研究論文では、パラメータ数が数億という超小型モデル「MobileLLM」が紹介された。MobileLLMは125M(1億2500万パラメータ)と350M(3億5000万パラメータ)の2つのバリエーションが開発されており、スマートフォンでの利用に最適化されている。

メタの研究者らによると、3億5000万パラメータのMobileLLMが必要とするメモリは約350MBに抑えられており、これは一般的なスマートフォンのDRAM容量の5%以下に収まるという。

グーグルのGemma 2 2B、GPT-3.5を超え、その実力

グーグルも小型モデル開発で主導権を握りたい考えだ。同社が2024年7月にリリースした「Gemma 2」は、そのコミットメントの現れと見て取ることができる。Gemma 2は、2B(20億パラメータ)、9B(90億パラメータ)、27B(270億パラメータ)からなる比較的小型の言語モデルファミリーだ。特にGemma 2 2Bの効率性が際立っており、注目を集めている。

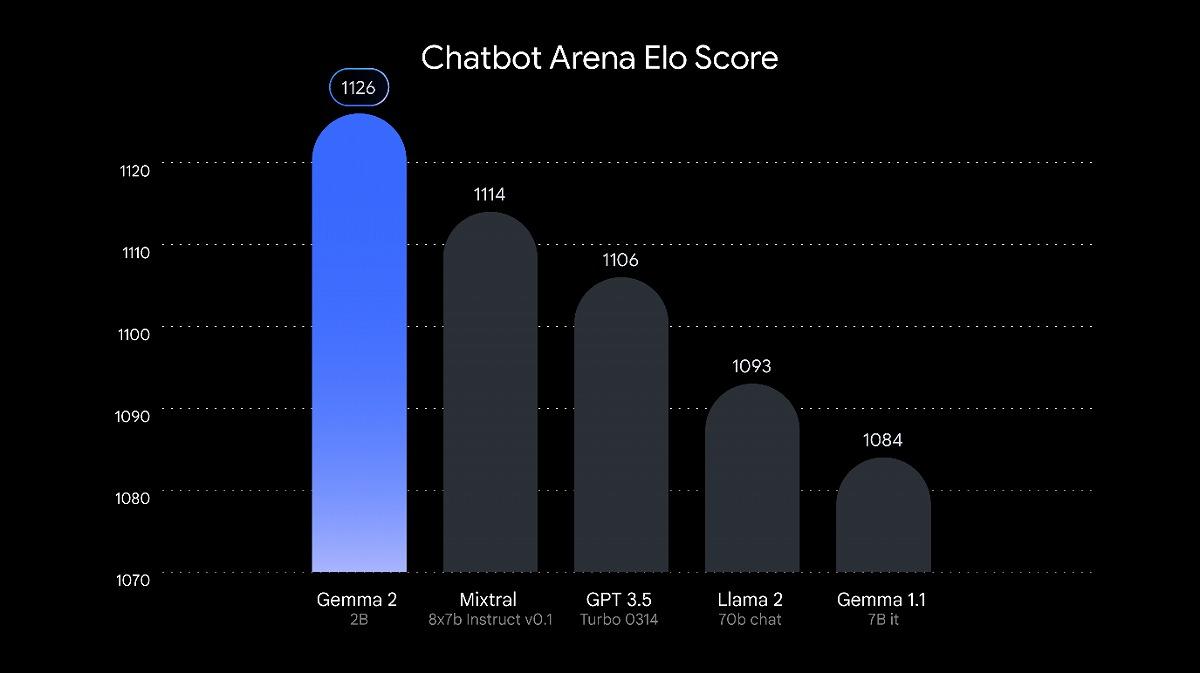

AI研究グループLMSYSの独立評価において、Gemma 2 2Bは1126点を獲得。Mixtral-8x7B(1114点)やGPT-3.5-Turbo-0314(1106点)を上回る結果となったのだ。この評価は、LMSYSが運営するChatbot Arenaと呼ばれるプラットフォームで実施されたもの。

同プラットフォームのリーダーボードによると、2024年8月6日時点では、合計127のモデルが評価対象となっており、総投票数は161万507票に達する。

リーダーボードの詳細を見ると、Gemma 2 2Bは52位にランクイン。51位のClaude-2.0(1132点)や、58位のGPT-3.5-Turbo-0613(1117点)と拮抗するパフォーマンスを示している。

特筆すべきは、(執筆時点では)Gemma 2 2Bが7197票という比較的少ない投票数でこのスコアを達成していることだ。一方、GPT-3.5-Turbo-0613は38935票と、はるかに多くの評価を受けている。

Chatbot Arenaの評価は、人間の選好に基づくペアワイズ比較を採用している。これは、2つのモデルの回答を並べて表示し、ユーザーがより良いと感じた方に投票するという方式だ。この手法により、モデルの実際の使用感に近い評価が可能となっている。

Gemma 2 2Bの成功は、AIモデルの大きさが必ずしもパフォーマンスに直結しないことを示唆するもの。高度なトレーニング技術、効率的なアーキテクチャ、高品質なデータセットの組み合わせにより、パラメータ数の少なさを補完できることが証明された格好となる。

Gemma 2 2Bはオープンソースで公開されており、研究者や開発者がHugging Faceを通じてアクセスできる。これにより、AIコミュニティ全体での知見の共有と、さらなる改良が期待される。 【次ページ】小型モデルの進化の詳細

関連コンテンツ

関連コンテンツ

PR

PR

PR