- 会員限定

- 2024/05/11 掲載

Grok-1.5とは何かをわかりやすく解説、イーロン・マスクのxAIがX(Twitter)も革新へ

Grok-1.5とは何か?GPT-4超えを目指して加熱するLLM開発競争

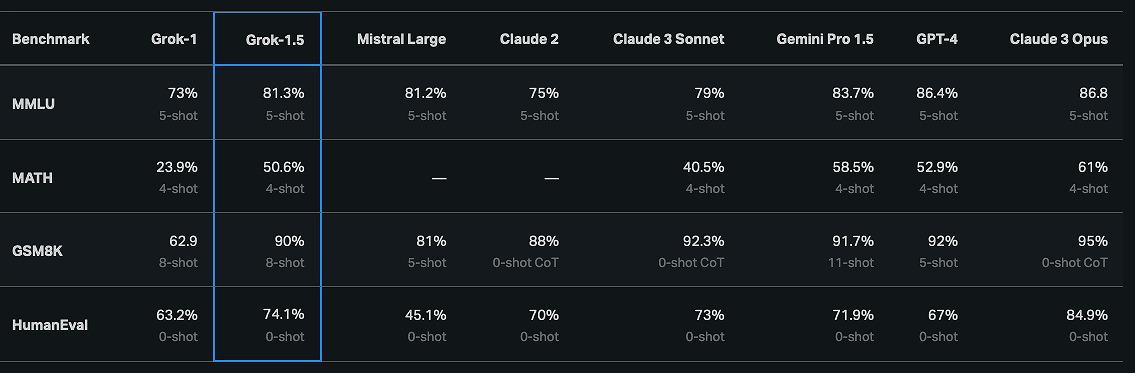

この数カ月、ポストGPT-4をめぐる生成AI開発競争が激化の様相だ。アンソロピックの「Claude3」、Cohereの「Command R+」、グーグルの「Gemini Ultra」など、新たなモデルが続々登場している。イーロン・マスク氏率いるAI企業xAIは2024年3月末、同社の大規模言語モデル「Grok-1」のアップグレード版「Grok-1.5」を発表。xAIによると、Grok-1.5はコーディングや数学タスクにおいて大幅な改善を見せており、高度な数学能力を測るMATHベンチマークでは50.6%、基礎数学能力を測定するGSM8Kベンチマークでは90%、コーディング能力を測るHumanEvalベンチマークでは74.1%のスコアを獲得したという。

Grok-1.5はOpenAIの「GPT-4」やアンソロピックの「Claude 3」に迫る性能を発揮しており、多様な分野の知識を測るMMLUベンチマークでも81.3%のスコアを記録。これはGrok-1の73%から大きく向上した数字となる。

さらに、Grok-1.5は最大12万8000トークンのコンテクストウィンドウを備え、長文の分析・要約・情報抽出タスクにも適しているとのこと。コンテクストウィンドウに関しては、同じ12万8000トークンのコンテクストウィンドウを持つGPT-4 TurboやCohereのCommand R+に並んだ格好となる。

ただ、現在利用可能な大規模言語モデルでは、Claude3シリーズが20万トークンでトップを走る。

xAIはGrok-1.5を限定公開しつつ、順次ユーザーを拡大していく計画だ。一方、後継モデルとなる「Grok-2」は現在トレーニング中で、マスク氏は「あらゆるメトリクスで現在のAIを超える」と意気込んでいる。テック系コンサルタントのブライアン・ルーメル氏は、「Grok-2はリリース時に最も強力なLLM AIプラットフォームの1つになるだろう。ほぼすべてのメトリクスでOpenAIを凌駕するはずだ」とGrok-2に対する大きな期待を表明している。

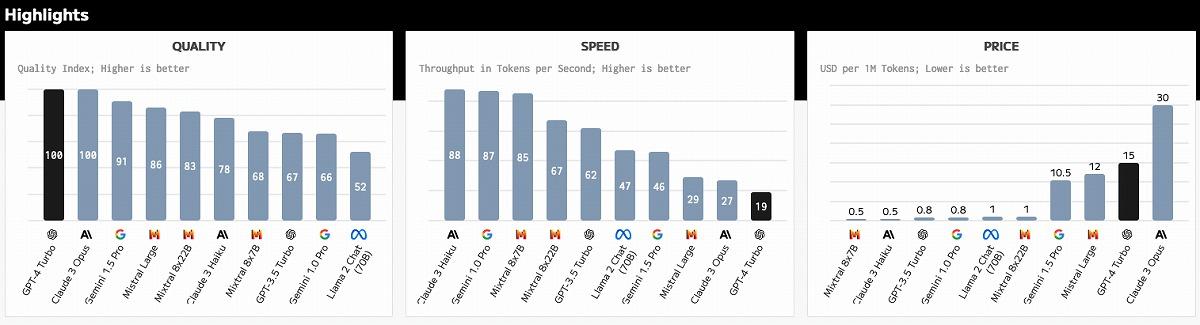

現時点ではGrok-1.5を使用できないため、実際のパフォーマンスを確認することができない。回答精度、日本語能力、生成スピード、価格などにおいて、現リーダーボーダーにどう食い込んでくるのか気になるところだ。

幅広い視覚情報を処理するマルチモーダルモデル、OpenAIも対抗へ

テキストだけでなく、さまざまなファイルを理解するマルチモーダルモデルの開発競争も熾烈化している。Grok-1.5の発表からわずか2週間後、xAIは同モデルのマルチモーダル版である「Grok-1.5V」を発表した。xAIによると、Grok-1.5Vはテキストの理解に加え、ダイヤグラム、チャート、スクリーンショット、写真など、幅広い視覚情報を処理できるという。Grok-1.5Vは多分野の推論から文書・科学図表・チャート・スクリーンショット・写真の理解に至るまで、さまざまな領域で既存のマルチモーダルモデルと肩を並べる性能を発揮しているという。

特にxAIが独自に開発した「RealWorldQA」ベンチマークでは、GPT-4VやClaude 3 Sonnet、Claude 3 Opus、Gemini Pro 1.5を上回る68.7%のスコアを記録し、現実世界の空間理解において際立った結果を示したとされる。

xAIはGrok-1.5Vの可能性を示すために7つの例を挙げている。ホワイトボードのフローチャートのスケッチからPythonコードを生成したり、子供の絵から物語を作成したり、ミームの説明や表のCSVファイルへの変換、デッキ中の腐った木材の特定など、多岐にわたるユースケースが紹介されている。

RealWorldQAは、700以上の画像とそれぞれの質問・回答のペアを使ってトレーニングされたベンチマークで、車両から撮影された画像や他の実世界のサンプルなど、多様な画像が含まれている。xAIはRealWorldQAをクリエイティブ・コモンズ・ライセンスの下で一般公開する予定だ。

競合の追い上げに対し、OpenAIもマルチモーダルモデルの開発を加速している。同社は2023年9月にGPT-4のビジョン機能とオーディオアップロード機能を発表したが、2024年4月にGPT-4 Turbo with Visionモデルを一般公開、これにより単一のモデルでテキストと画像の両方を処理できるようになった。

GPT-4 Turbo with Visionは、すでにいくつかの顧客に活用されている。自律型AIコーディングエージェントのDevinを開発したスタートアップCognitionは、同モデルを使用してユーザーに代わって自動でコード生成を行うプラットフォームを展開。また、ヘルスケア&フィットネスアプリのHealthifyでも、食事の写真から栄養分析と推奨事項を提示するためにGPT-4 Turbo with Visionが活用されているという。 【次ページ】Xで話題のニュースを要約する機能に採用

関連コンテンツ

関連コンテンツ

PR

PR

PR