- 会員限定

- 2023/03/08 掲載

AIガバナンスとは何か? AI開発のガイドラインに「倫理」を組み込む方法

AIガバナンスとは何か?

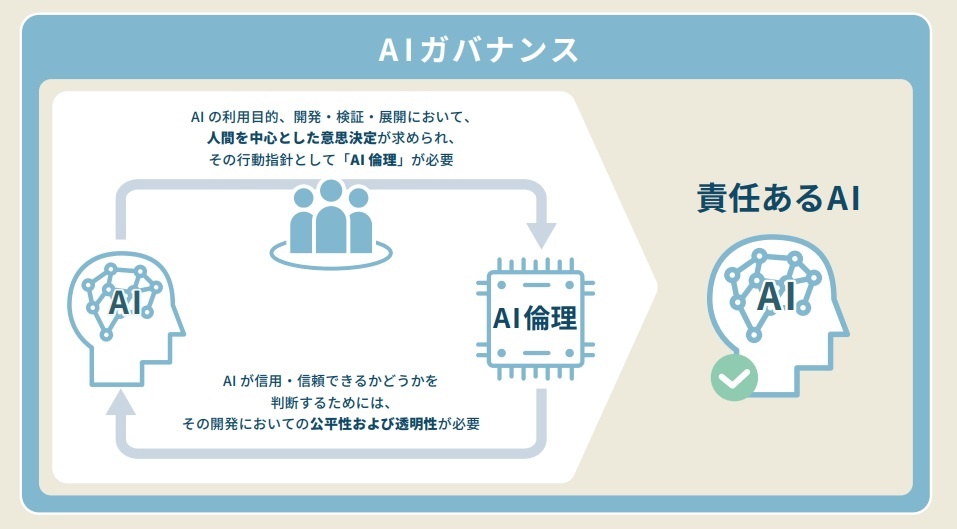

AIガバナンスとは「AIをどのように扱い、管理・統治して運用するかに関する基本的な考え方および枠組み」のことを指します。AIガバナンスを正しく理解するためには、「責任あるAI(レスポンシブルAI)」「AI倫理」という2つの言葉を理解する必要があります。

「責任あるAI(レスポンシブルAI)」

企業の社会的責任とAIガバナンスに基づいて設計され、適切な方法論で構築・展開・運用されるAIを「責任あるAI(レスポンシブルAI)」と言います(アクセンチュアが提唱)。大切なことは、どのようなAIであっても、その根本で「人間中心のデザイン(意思決定の中心には常に人間がいる)」を貫くことです。

「AI倫理」

そして人間の社会に道徳や法律があるように、AIにも「責任あるAI」であるために守るべき規範が存在します。それが「AI倫理」です。

これらの関係性を整理すると、AIを使うサービスの開発者は「AI倫理」に基づいて設計を行い、企業は自社の社会的責任を全うするために「責任あるAI」を実装しなければなりません。これらを包括的に管理する大きなテーマが「AIガバナンス」であると言えるでしょう。

AIガバナンスが注目されている背景は?

現代のビジネスシーンでは、AIを実装したサービスの公平性や公正性、透明性を担保するための「AIガバナンス」が企業に求められています。それは、AIの活用範囲が拡大し続けているためです。人命に関わる医療、企業内の人事、社会インフラの維持など、個人の人生にまで影響を及ぼす段階に達しています。AIの普及は、そのまま裏返すと「AIが何らかの意図しない動作(社会的に許されない反応)」をした場合、企業や社会にとってリスクになりうるということです。

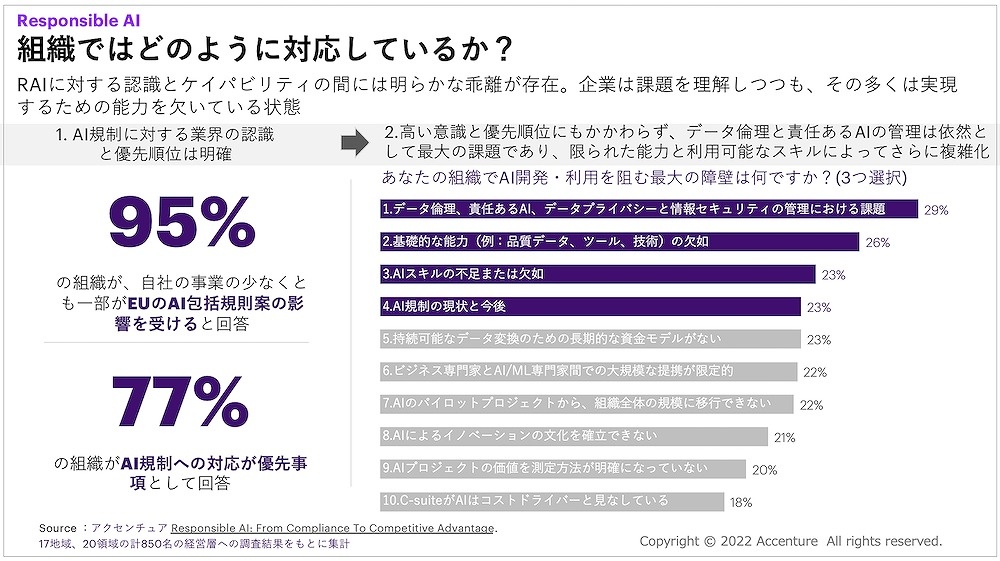

一方で、社会情勢としても企業に倫理を求める動向が強まっています。市場調査によると、消費者の75%は「倫理に反する企業の製品・サービスは購入・利用しない」と回答しています(Salesforce「EthicalLeadership and Businessreport」)。

しかし経営者や事業責任者は、自社が「間違わない」ために消極的な立場であってはなりません。社会的倫理に対する意識の高いアプローチこそが、自社の競争力や差別化要因を生み出す時代となっているのです。

つまり、今日における付加価値の源泉は、企業がいかに社会的責任を果たし、顧客から信頼されているかにかかっていると言えるでしょう。

AIガバナンスが注目されている理由は複合的ですが、ビジネス現場でのAIOpsの拡大も挙げられるでしょう。AIOpsはIT運用に大量の運用データを収集・加工し、AIや機械学習を活用して高度化・効率化・自動化を実現する考え方です。業務現場でAIをどのように活用するかは、まさにAIガバナンスの領域と重なるからです。

経産省が示す「我が国のAIガバナンスの在り方」とは

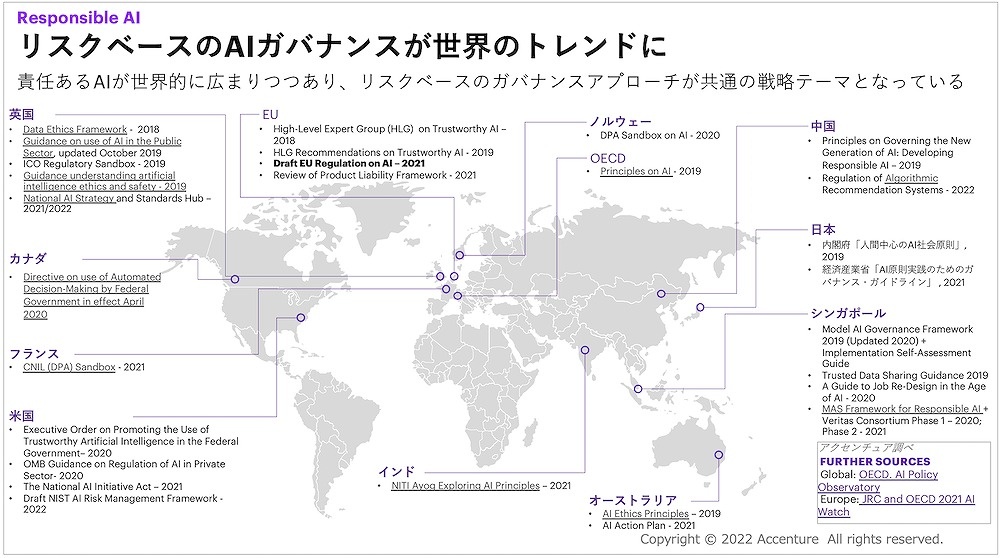

社会の変化に対して国も敏感に反応し、AIがバンナンスへの取り組みを推進しています。2020年から継続開催されてきた「AI社会実装アーキテクチャー検討会」(経済産業省)は、2021年から「AI原則の実践の在り方に関する検討会」と名を変えて活動を継続しており、2021年7月に『我が国のAIガバナンスの在り方』と題した報告書と、法的拘束力のない分野横断的なガイドラインとして「AI ガバナンス・ガイドライン(AI原則実践のためのガバナンス・ガイドライン)」を公開するに至っています。

AI ガバナンス・ガイドラインでは、国内外のAI原則やルール形成の動向を構造的に明示し、「日本の在るべきAIガバナンスの全体像」を提示しています。

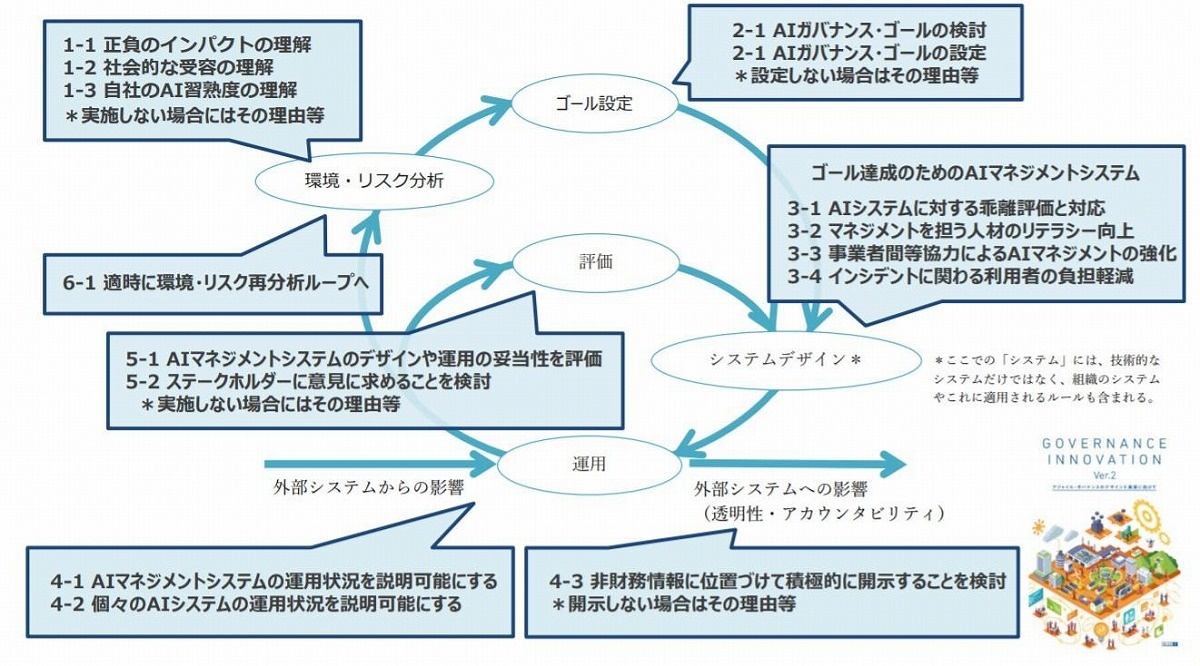

AI ガバナンス・ガイドラインには、AIシステム開発者のみならず、AIシステム運用者への実務的な指針が記載されています。また、マネジメント体制の整備とリスク管理のための行動目標を「アジャイル・ガバナンス(常に周囲の環境変化を踏まえてゴールやシステムをアップデートしていくガバナンスモデル) 」の枠組みに沿って示されています。

責任あるAIを実現する上での課題

責任あるAIを実装し、企業全体へAIガバナンスを浸透させたいという経営者から、筆者は数多くのご相談を頂戴しています。その中でもよくあるパターンを整理すると、次の2つのケースが大半を占めます。ケース1:AI倫理原則は策定したが体制構築が全然できていない

日本ではAI倫理原則を策定する企業が急増しています。特に製造業業界では進んでおり、AI倫理原則を社内外へ公表する大手企業も少なくありません。しかし経営層からは、「方針は立てたものの、実行力のある体制構築ができていない」という相談を頻繁にいただきます。

このケースでは、CDO(最高デジタル責任者)のような組織内の然るべき責任者を中心として専任チームが組成されているかどうかが、その後の展開を分けます。「AI倫理推進チーム」や「データガバナンス室」など名称はさまざまですが、トップダウンで決定権を持つ組織かどうか、必要な予算が割り振られているかどうかがポイントです。

こうした企業の場合、実践に裏付けられた知見を持つAIソリューションのプロバイダーをパートナーとすることが状況の打開策となりえます。

ケース2:自社のAIガバナンスに不安を持っている

次によくあるご相談では、すでにPoCなどでAIのプロジェクトを多数経験してきた企業に多いパターンです。AIが倫理的・社会的に許されないアウトプットを出した事例(詳しくは後述)もしっかり参考にしており、AIの取り組みが何らかのリスクを背負うことにつながるのではないか、と不安を持っているお話もよく伺います。

こうしたケースでは、ヒアリングを重ねていくと「AI開発フローへのガバナンスの仕組みの導入」が取り組むべきテーマであると焦点が定まってきます。AI導入をポイントソリューションとせず、複数のAIを連携させるハブの導入やルールの整備、AIに関わる人材育成などで企業全体のAIガバナンス強化が課題解決への第一歩です。

【次ページ】暴走するAI、差別するAI

関連コンテンツ

関連コンテンツ

PR

PR

PR