- 会員限定

- 2025/03/03 掲載

ガートナーが警鐘「ナメがち」生成AI活用リスクが怖すぎる…対策「6ステップ」とは

生成AI活用の「明暗」はどこで決まるのか

情報の検索や作成、利用、理解の方法を一変させ、従業員の生産性を抜本向上させる存在として企業から大きな期待を集める生成AI。その活用で今後、鍵を握るとされるのが、自社データによる生成AIの学習である。生成AIを単独で用いる場合、生成可能なコンテンツはLLMが学習に用いたインターネット上のデータの範囲に限られる。

だが、質問や指示に自社データを含めて回答に活用させるプロンプトエンジニアリングや、生成AIの回答時に指定したDBを検索・参照させるRAGなどを用いることで、社内データに基づくコンテンツ生成も可能となり、回答精度とともに利便性も大きく高められる。実際、マイクロソフトとグーグルの生成AIツールであるCopilot for Microsoft 365やGemini for Google Workspaceなどでも、指定のデータソースによる学習がすでに可能となっている。

その一方で、生成AI利用に関しては、誤った学習による機密情報の社外漏洩など、「社内データの安全」を危惧する声も高まっている。

この安全性への懸念について、「無論、その点はマイクロソフトやグーグルも認識しており、Copilot for Microsoft 365/Gemini for Google Workspaceとユーザーとのやり取りは組織内でのみ行うほか、プロンプトデータによるLLMのトレーニングは実施しないなどの対策が表明されています」と語るのは、ガートナー ディレクター, アナリストのマックス・ゴス氏だ。

ディレクター, アナリスト

マックス・ゴス氏

ただゴス氏によると、生成AIにより生じる情報リスクはこのほかにも存在するという。そのリスクとは、以下の3つだ。

- データの過剰共有

- 不正確さ

- データの無秩序な増加

この3点、具体的にどのような危険性があるのだろうか。順番に見ていこう。

Copilot導入で生じる「ある懸念」

まず最初の「データの過剰共有」に関しては、企業ではこれまで情報漏洩対策などを狙いに、データの重要度と社員の権限を突き合わせてアクセスを適切に制御する仕組みが整えられてきた背景を知る必要がある。すなわち、重要度の高いデータには、当然、役職の高い社員のみがアクセスできるという状態があったのだ。ここで問題となるのが、データの重要性を適切に設定できておらず、本来は認めるべきでない社員に対しても共有を過剰に許しているデータである。過剰共有は従来から存在したが、大量データの分散管理により、いわばデータの山の中に埋もれる形でそれほど課題視されてこなかった。

だが、こうした状況は生成AIにより抜本的に変わるとゴス氏は指摘する。

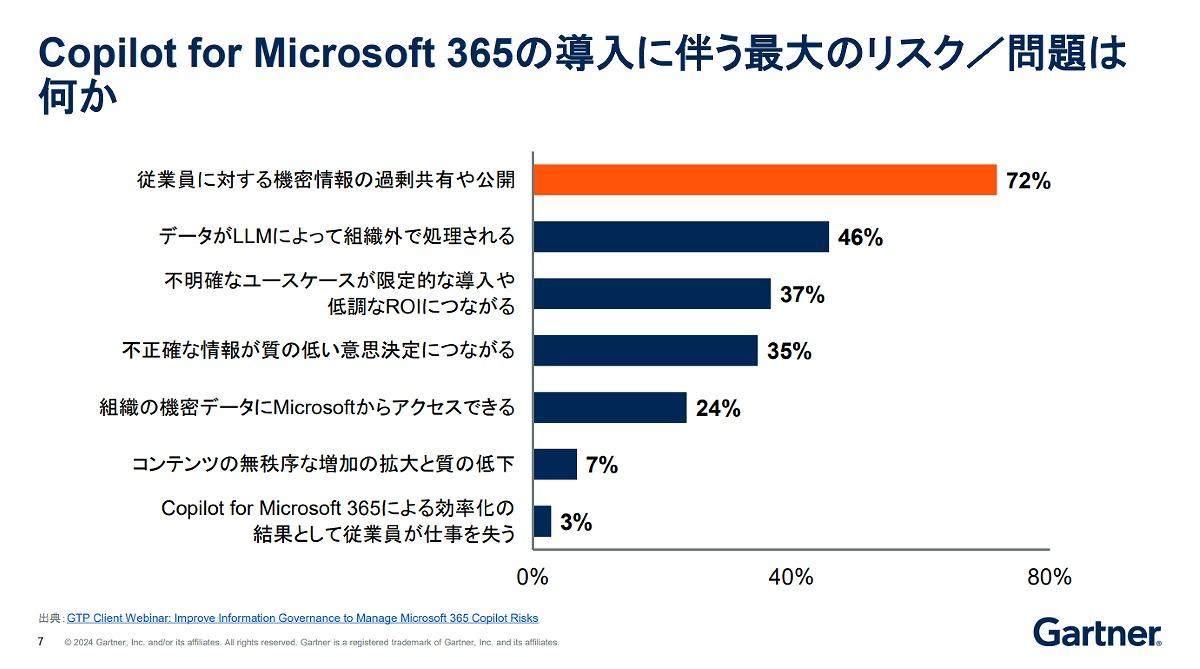

ガートナーの調査でも、Copilot for Microsoft 365の導入に伴う最大のリスク/問題として全体の72%が「従業員に対する機密情報の過剰共有や公開」を挙げているという。

「生成AIは指定されたBD内の過剰共有も含めたデータのすべてを学習しコンテンツ生成に利用します。結果、過剰共有データに基づく回答生成により、機密データの社内漏洩が生じることも十分にあり得ます」(ゴス氏) 【次ページ】生成AIの「手軽さ」は逆に危ない?

関連コンテンツ

関連コンテンツ

PR

PR

PR