- 会員限定

- 2017/10/04 掲載

CEATEC 2017で見えた「次世代の」IoT活用、7社ブースを詳細レポート

オムロン、デンソー、KDDI、シャープ、富士通ら

オムロンはディープラーニングで「自動運転サポート」を進化させる

オムロンのブースでは、今年で4世代目になる卓球ロボット「フォルフェウス」(FORPHEUS)のデモが行われていた。昨年から時系列ディープラーニング(RNN)が搭載され、賢くなったフォルフェウスは、ピンポン球の打ち方を予測できるようになった。さらに今年はスマッシュへの対応と、技能レベルに合わせてラリーを楽しめる工夫も凝らされた。たとえば、初心者には難しいサーブの代替が行えるようになった。一方、上級者の場合には、ラリーの状況をロボット側で判断し、声をかけたり、卓球台に当たるピンポン球の位置によって、BGMが重層的に流れていく仕組みなどを取り入れたりすることで、機械と人のコミュニケーションを高めている。

また前出の時系列ディープラーニングで、スマッシュを打つ気配を先読みして球筋を予測。「球の追従アルゴリズム」の高速化によって、約60㎞/hの高速スマッシュを受けることが可能になった。ロボット同士の同時制御も見逃せない進化だろう。垂直多関節ロボット「Viper 650」がトスを打ち上げ、0.01秒以下で高速同期し、スイング用のパラレルリンクロボットがサーブを繰り出す連携プレイを世界で初めて実現した。

FA分野では、近未来の工場で活躍する物流ロボットを紹介。独自のAIを搭載したモバイルロボット「LDシリーズ」を2台用意し、人や障害物を自動で回避しながら、最適ルートで目的地まで荷物(最大130㎏)を運ぶ搬送デモを実施。前方の上下2ヵ所にレーザースキャナを搭載し、周りの環境を計測しながら、SLAM(Simultaneous Localization and Mapping)技術により、移動可能な範囲の地図を作成する。

また天井方向にもカメラがあり、工場のレイアウトが変わっても、上方の情報を頼りに目的地にたどり着けるという。この自動搬送ロボットは、すでに滋賀県草津市の同社工場で、PLC(プログラム・ロジック・コントローラ)関連の部品製造のために使われている。韓国・仁川空港でもドリンクサーバとして実証実験が行われたそうだ。

もう1つ紹介したいのがモビリティ分野の展示だ。来るべき自動運転時代を見据え、同社が出展していたのが「ドライバー見守り車載センサー」を搭載したコックピットだ。

昨年も同様の技術が紹介されていたが、今回は時系列ディープラーニングをさらに進化させ、ドライバーの運転集中状態に関して、「運転の状況を注視しているか」「どれだけ早く運転に復帰できるか」「運転席にちゃんと着いているか」という3つの指標で同時に判断している。

また同社の顔画像センシング技術である「OKAO Vison」にも前出の時系列ディープラーニングを適用させ、マスクやサングラスをかけてドライバーの顔が隠れていたとしても、まばたきや顔の向きなどを正確に認識できるようになったという。

デンソーはVR+車で「空飛ぶ世界旅行」を提案

自動車部品関連メーカー大手のデンソーは、同社の要素技術を応用しつつ、従来の枠から飛び出すユニークなアイデアを披露した。特に目立っていたのは「Vehicle VR Actuation Technology」と呼ばれる技術だ。電動モビリティ(超小型EVコムス)に、VRシステムをまるごと実装する発想だ。自社制作したVRコンテンツを活用し、映像に合わせた動きを車体に加えて、未知の体験を実現するもので、空飛ぶ車から世界旅行を体感できるデモを行っていた。

さっそく筆者もトライしたが、Oculus Riftを装着してスタートすると、実際に車が前後に動いたり振動することで、あたかも空に飛び立つような浮遊感を味わえた。ハンドルを回す腕は「Leap Motion」によりトラッキングされ、Oculus Rift 越しにその様子が見える。将来的には、ハンドルやクラクション、アクセル・ブレーキなどをスイッチし、何かインタラクティブ性を持たせたいという。

このトライアルでは、マンハッタン、インドネシアの島、モスクワのクレムリンの三か所をまわった。車から下をのぞくと、リアルな街並みや海が目に飛び込んで美しかった。サイドミラーにも背後の風景が映り込む手の入れようだ。エンターテインメント分野などで活用できそうだ。

またオープンイノベーションの取り組みも紹介。超音波ビーコンを活用した屋内位置情報システムと、アーティストの感性を融合した「驚異の学校」を展示。

エデュケータユニットのunworkshop(アンワークショップ)とのコラボ作品で、伊能忠敬の地図や、自動車の歴史などを音声で学べるアイデアだ。

床に年表(位置)を示すマーカーがあり、そこに子どもが立つと、上方の超音波ビーコンから特定IDがデバイス側(スマートフォン)に送られる。サーバとつなぎ、そのIDに紐づいた歴史学習用の説明音声がデバイス側から流れる仕組みだ。

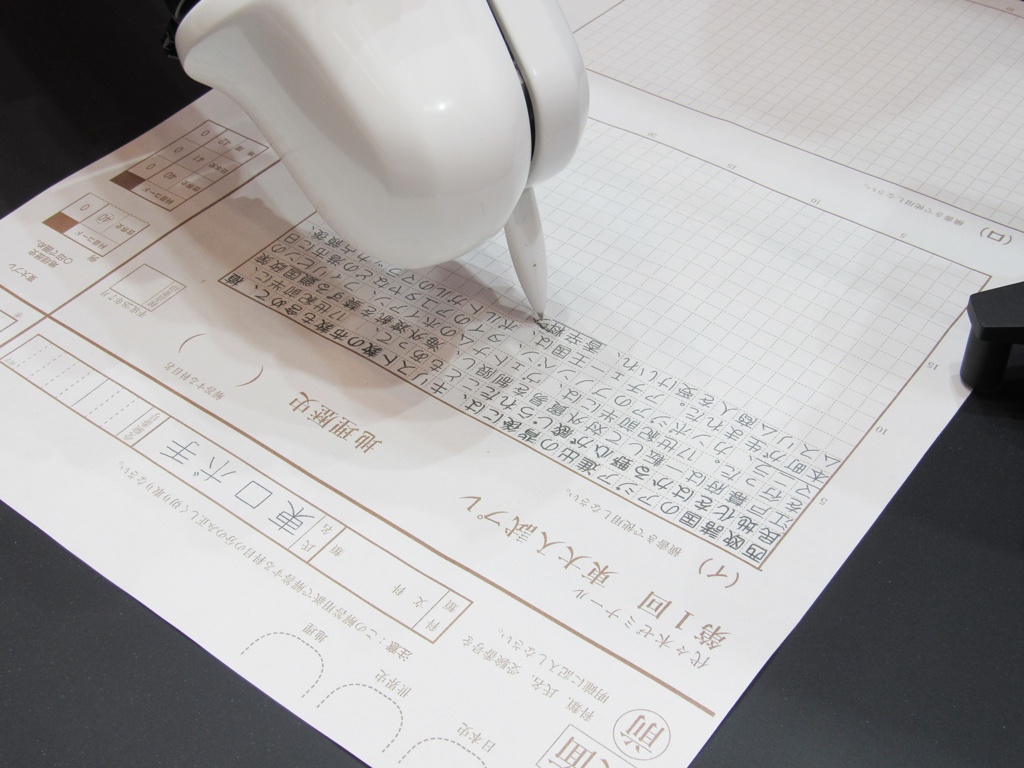

また人工知能の答案を筆記する解答代筆ロボットアーム「東ロボ手くん」も展示されていた。話題になったので、ご存じの方も多いかもしれないが、国立情報学研究所が中心となって取り組んでいたAIプロジェクト「ロボットは東大に入れるか」の一環として、AIが導き出した答案を解答用紙に筆記するためにデンソーが開発した代筆用ロボットアームだ。

人間の腕に近い関節構造で立体的かつ柔軟な動きが可能な産業用多関節ロボット「VS-060」(デンソーウェーブ製)を2台採用し、ペンを使って書くことにこだわっている。

右腕のボールペンによって、一定の筆圧をキープしたまま長時間連続で筆記でき、左腕のカメラで解答用紙の位置や向きを確認しながら、6㎜角のマス目の解答用紙に正確に文字が書ける。

文字種はJIS標準漢字約7000字に対応し、漢字・かな・数字・英字の書き分けが可能だ。記入が終わると右手を挙げて、解答用紙の裏返しを求める。目に見えない安全柵(エリアセンサ)が机上に設定され、危険を察知するとロボットが自動停止してくれる。

KDDIは5G活用を視野に入れ、「遠隔操作」をデモ

KDDIブースでは2つの展示に注目が集まっていた。1つはテレイグジスタンスのデモだ。ごく簡単にいうと遠隔操作なのだが、ある対象と遠く離れながら、あたかもそこにいるような感覚が得られる技術だ。遠隔地から自分の分身となるアバターロボットを動かせるもので、2000年代前半にはネットワークロボットとしても注目を集めた。当時はネットの回線が遅く、レイテンシ(遅延)の問題もあったが、もうすぐ5Gの時代に突入する。そうなればリアルタイムに近い遠隔操作が違和感なく実現できるだろう。

同ブースでは、テレイグジスタンスの第一人者である東大名誉教授の舘暲(たち すすむ)氏が開発した「TELESAR V」が使われた。2017年には舘氏が会長となり、ベンチャー企業のTelexistenceが誕生している。KDDIも同社に出資しているそうだ。

今回のデモは5Gではなく、Wi-Fiが使われたが、オペレータが腕や指を動かすと、ロボットがすぐに追従し、コップに入ったビー玉を上手に空コップ側に移していた。

さらにこのロボットが面白い点は、視覚や聴覚だけでなく触覚伝送技術が装備されていることだ。たとえばロボットのアームを押し返せば、オペレータ側にもその力がセンサーによってダイレクトに伝わる。布などの細やかな感触さえも伝えられる。そうなると近い将来、手術ロボットの遠隔操作にも応用できそうだ。

※この動画はCEATEC 2017で撮影されたものではありません。

もう1つKDDIブースで面白かったのは「自由視点VR」と呼ばれる技術だ。複数のカメラで撮影した映像から、その被写体を3Dモデル化し、その瞬間・空間をどんな視点からでも観察できる。VRコンテンツをリアルタイムに合成できる手法を考案し、撮影と同時に自由視点VRの視覚体験が可能になった点が大きなポイントだ。

実際のデモでは、スポーツクライミングの状況を追った16台のHDTVカメラ映像をシステム側に送り、ユーザー視点を選んでモデルをリアルタイムに生成し、実写のテクスチャーを貼り付けている。視点を変更するとリアルタイムに映像も切り替わる(遅延時間は約1秒)。まだ検討の段階だが、将来的にはスタジアムで撮影した映像を瞬時に取り出してモデル化して、ハイライトシーンとして表現することなども考えているそうだ。

【次ページ】シャープの警備ロボットが米国大手警備会社に納入された?

関連コンテンツ

PR

PR

PR