- ありがとうございます!

- いいね!した記事一覧をみる

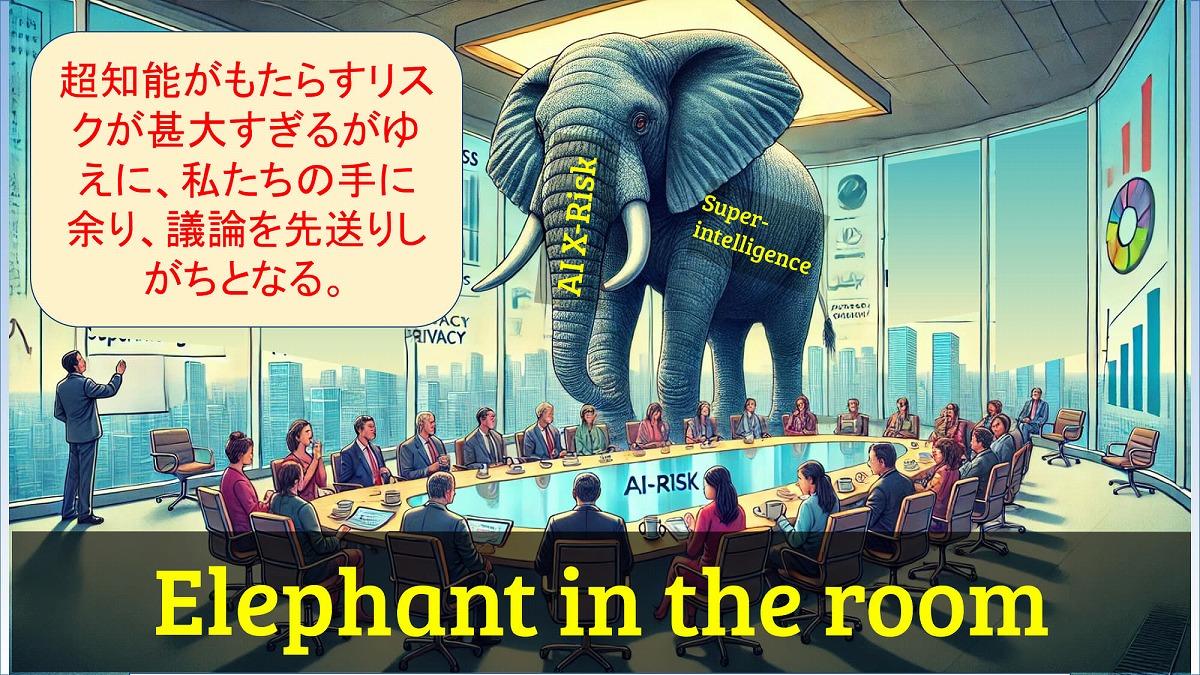

なぜ、「AIのリスク」に関する議論は進まない?

これは、問題の規模や不確実性があまりに大きくて想像しづらく、日常的な感覚では扱いづらいテーマであるためだ。さらに、「人類滅亡」という重いシナリオを直視するには心理的抵抗も大きく、議論自体が先送りされがちである。

このような「明白で巨大」な問題が「Elephant in the room(部屋の中の象)」と呼ばれるように、重要視されなければならないにもかかわらず、社会全体で十分に議題として取り上げられないまま放置されているのが現状だ。しかし、もし超知能リスクが現実化すれば、その被害は計り知れず、早期のリスク管理策の構築が急務と言える。

近年、ChatGPTなどの生成AIが登場したことで、改めてAGI(汎用人工知能)の発展可能性が注目を集めている。AGIの定義は未確定ながら、しばしば「人間と同等、あるいはそれ以上の汎用的知能を持つAI」と説明され、各企業や研究機関が技術的・理論的な探求を進めている段階だ。

そして、このAGIがさらに進化して、あらゆる分野において人類を凌駕する能力を持つSI(超知能:Super Intelligence)に至った場合、シンギュラリティ(技術的特異点)が起こると予測されている。

このシンギュラリティがまさに、存在論的リスクを具体的な現実に変えてしまう大きな要因であると言われている。すなわち、AGIからSIへと至る急激な技術進化が、これまで「空想の産物」に近いと見なされていたXリスクを現実の脅威へと変貌させる可能性を秘めているのだ。

ここから先は、AIのさらなる発展がもたらすリスクをより具体的に解説し、我々がどのように備えていくべきなのかを考えていく。技術の進歩がもたらす恩恵は大きいが、その裏側で潜むリスクにも目を向けなければならない。議論が敬遠されがちなテーマこそ、今こそ社会全体で真正面から取り組む必要があるのではないだろうか。

この記事の続き >>

-

・なぜ、「AIのリスク」に関する議論は進まない?

・技術が発展した未来の世界とは?

・AIがもたらす軍事・経済覇権競争:止まらぬ開発レースの行方

・道具的副目標の収斂:SIが人類に対して慈悲深くなる保証はない

・制御不可能:SIの制御に向けた挑戦

・人類は追いやられてしまう可能性がある

・AI共生時代に人間の価値を探求する「ポストシンギュラリティ共生学」

・「人間のように考える」全脳アーキテクチャはSIとの橋渡しに

今すぐビジネス+IT会員に

ご登録ください。

すべて無料!今日から使える、

仕事に役立つ情報満載!

-

ここでしか見られない

2万本超のオリジナル記事・動画・資料が見放題!

-

完全無料

登録料・月額料なし、完全無料で使い放題!

-

トレンドを聞いて学ぶ

年間1000本超の厳選セミナーに参加し放題!

-

興味関心のみ厳選

トピック(タグ)をフォローして自動収集!