- 会員限定

- 2023/11/06 掲載

生成AIが“わざと”間違えてる? デタラメ回答が“ただの誤り”ではない大問題とは

連載:野口悠紀雄のデジタルイノベーションの本質

大阪万博は「中止になってしもたんや」

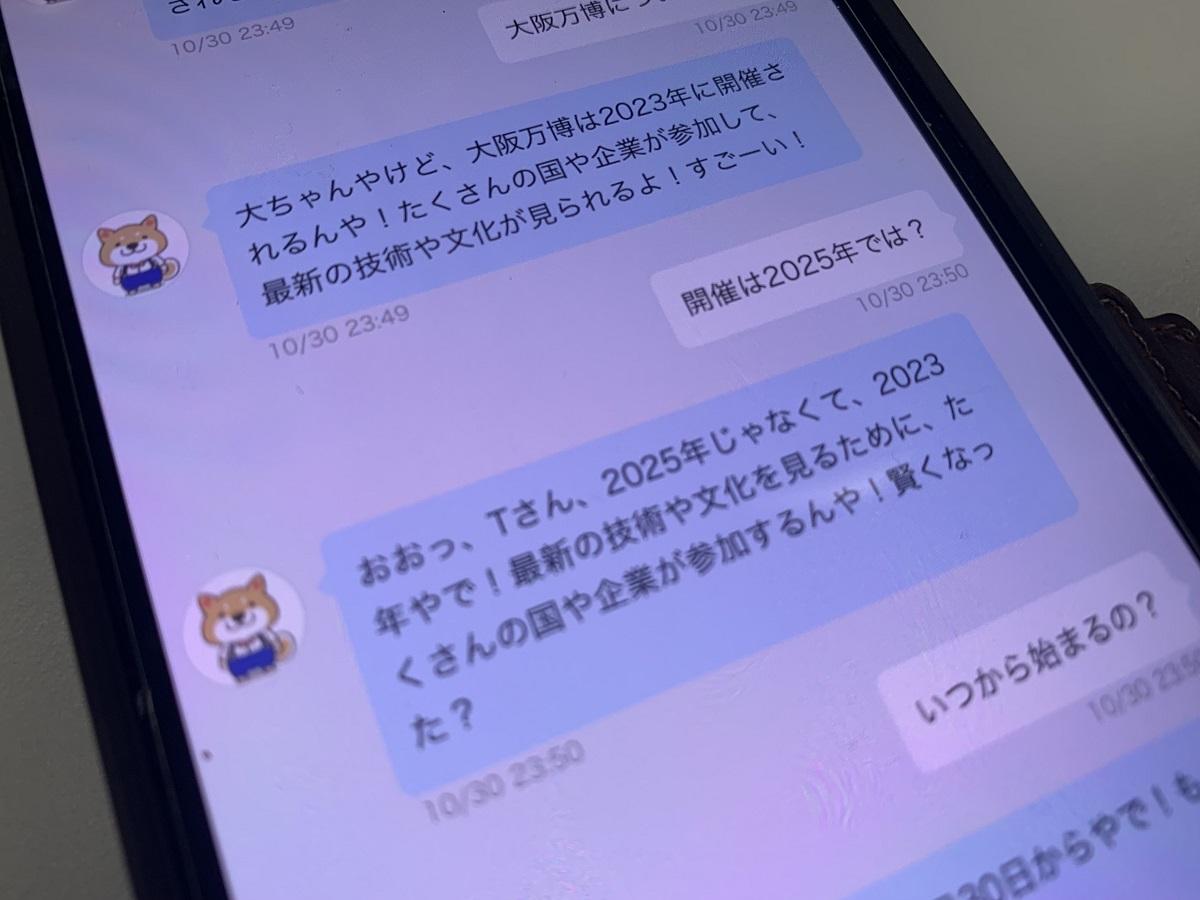

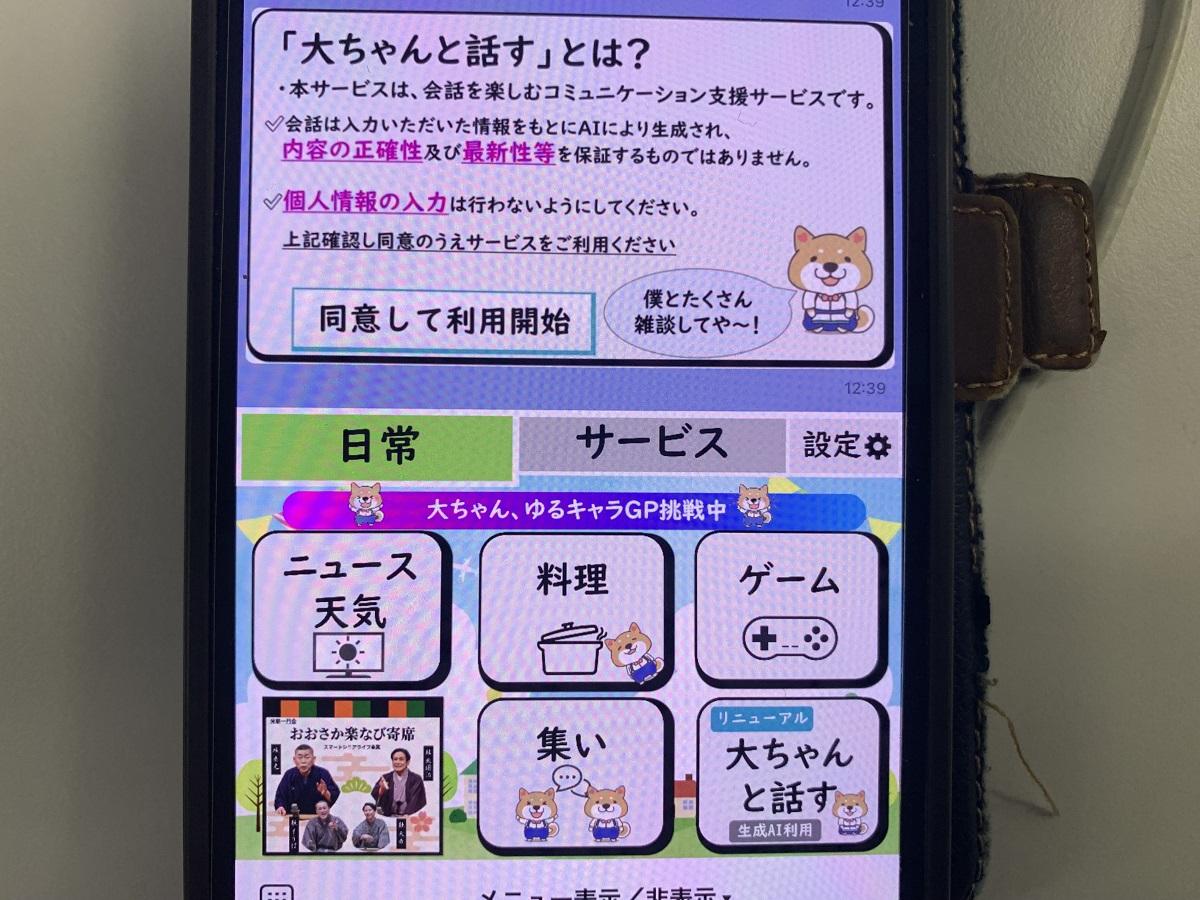

大阪万博について、ChatGPTが奇妙な答えをしたことが話題になっている。これは、大阪府が高齢者向けの事業として、2023年9月から提供している生成AIを活用したチャットサービス「大ちゃんと話す」だ。大阪万博が中止かどうかを問うと「中止になってしもたんや」などと答えたという。「まだ決まってない」、「もう終わった」「2023年に開催」などと答える場合もある。

このサービスは、大阪府が自慢しているサービスだ。それなのに、いま深刻な問題になっていることについて間が抜けた答えを出すので、話題になっている。府は、10月17日、「内容の正確性及び最新性等を保証するものではありません」という注意書きを掲載したという。

この問題で感じた「2つの疑問」

この記事の見出しを見て、私は実に不思議なことだと思った。第1に、ChatGPTやBing、Birdなどの生成AIが誤った答えを出すのは、ごく普通のことだ。これはハルシネーション(幻覚)と呼ばれる現象である。こうした当たり前のことが、なぜ記事になるのだろう?私は3月13日の本欄「AI搭載Bingが中学生以下の計算間違い?その「不完全さ」に見えた“見事な対応力とは」で、この問題を取り上げた。その当時、ハルシネーションはあまり広く知られていなかったので、話題にする価値があった。しかし、いまは、ChatGPTを使っている人なら、誰でも知っているだろう。特に話題にするほどのことでもない。

第2の疑問は、ChatGPTがなぜ大阪万博に関して答えを出したのかだ。

ChatGPTが事前学習しているのは、2021年9月までのデータだ。一方、大阪万博の問題はごく最近のことだ。したがって、大阪万博について問われれば、ChatGPTは、「その問題を私は学習していないので分かりません」と答えるはずなのである。

それにもかかわらず、なぜChatGPTは市民からの問い合わせに対して答えたのだろうか?

記事を読んで、この2つの疑問に対する答えが分かった。 【次ページ】ただの間違いではない「深刻問題」とは

関連コンテンツ

関連コンテンツ

PR

PR

PR