- 会員限定

- 2023/08/19 掲載

生成AIでGPU不足深刻化、NVIDIA新投入のGH200とは? メタやテスラが抱える驚きのGPU数

シリコンバレーでは「GPU不足」が話題

ChatGPTなど、生成AIへの関心・需要が高まる中、大きな課題としてシリコンバレーで注目されるトピックがある。それが「GPU不足」だ。OpenAIのChatGPT、グーグルのBard、AnthropicのClaudeなどいわゆる生成AIチャットボットの核となっているのが大規模言語モデル(Large Language Models、LLM)。ChatGPTではGPT3.5やGPT4、BardではPaLM2という大規模言語モデルがチャットボットの裏で稼働している。

この大規模言語モデルの開発・運用において必須となるハードウェアがGPUである。AI開発用のGPUにおいては、NVIDIAがほぼ独占的なシェアを占有しているが、需要の急速な高まりに供給が追いつかず、「GPU不足」が深刻化しているといわれているのだ。

テスラのAI部門ディレクターを務め、現在OpenAIに所属するアンドレイ・カルパシー氏によると、NVIDIAのフラッグシップGPUである「H100」の需要が急拡大しているという。特にH100に関して、誰が、どれほど入手したのか、という話題がシリコンバレーで注目されている。

AI開発に関して、これまでNVIDIAが2020年にリリースした「A100」というGPUに関する話題が多かったが、生成AIへの関心が急速に高まり、マイクロソフトやグーグルなどテック大手の取り組みが本格化したことで、GPU取得をめぐる資金量も大幅に増加、現在では2022年にリリースされたより高価な「H100」の入手をめぐる競争が激化している。

米メディアが伝えたGPUの現地価格は、A100が1台約1万ドル、H100は1台で約4万ドルほどといわれている。大規模言語モデルの開発・運用では、数千~数万に上るGPUが使用されることが多く、動く資金も大きくなる。

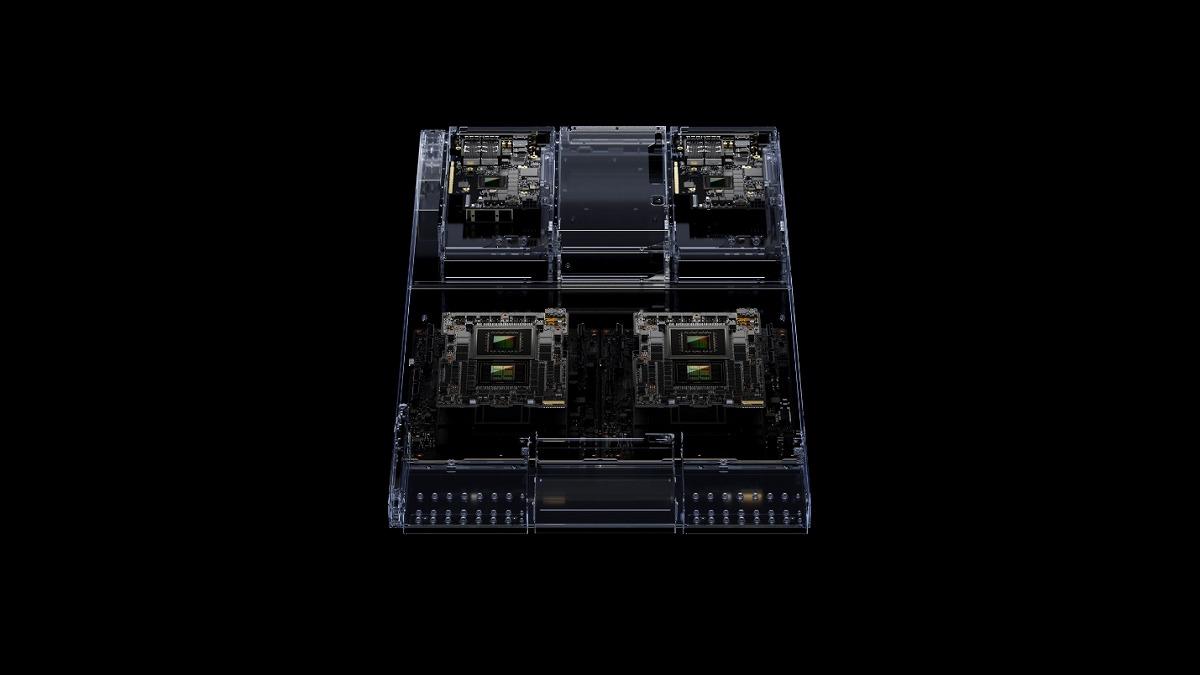

NVIDIAが発表した最新のGPUシステム「GH200」

こうした状況も手伝って、NVIDIAがSIGGRAPH 2023で発表した最新のGPUプラットフォーム「GH200」に対する関心も大きなものとなっている。このGH200は、H100をベースとするGPUプラットフォームであるが、生成AI向けにデザインされており、通常のH100よりも大きな容量と帯域幅を特徴としている。価格は明らかにされていない。

注目点の1つは、最新メモリ「HBM3e」が搭載されること。GH200は、HBM3eメモリを搭載した世界初のチップになる予定だ。これにより、GPU1つあたりのローカルメモリを96GBから144GBと50%増加させることが可能となる。また、デュアルセットアップも可能で、この場合、最大282GBのメモリを搭載でき、最大でメモリ容量を3.5倍、帯域幅を3倍増加させることができるという。

HBM3eメモリを搭載したGH200ベースのシステムは、2024年第2四半期から販売開始される予定。また、HBM3eよりも少し古いモデルであるHBM3メモリを搭載したGH200は、現在すでに生産開始されており、年内に発売される予定だ。 【次ページ】ChatGPT開発に必要なGPU数とは?

関連コンテンツ

関連コンテンツ

PR

PR

PR